Abstract

Il presente contributo riflette una lettura del sistema di valutazione nel contesto della programmazione per lo sviluppo rurale e, in quest’ambito, dei progressi compiuti a conclusione del ciclo di valutazione on-going (2007-13). Nel passaggio alla fase di valutazione “durante il periodo della programmazione” (2014-20), caratterizzata da una maggiore complessità, la lettura complessiva del sistema di valutazione dello sviluppo rurale 2007-13 offre l’opportunità di trarre insegnamenti dalle lezioni dell’esperienza e di riflettere sulle possibilità di crescita di una “cultura della valutazione” diffusa tra le amministrazioni, i valutatori e gli altri stakeholder dei Psr.

Introduzione

La trasmissione delle Relazioni di valutazione (Rdv) ex post dei Programmi di Sviluppo Rurale (Psr) 2007-2013 ai Servizi della Commissione europea (Ce), prevista per il 31 dicembre 2016, chiude il ciclo della valutazione on-going.

Questo si è contraddistinto per la realizzazione di percorsi regionali di sistematica consultazione dei valutatori per l’attuazione, la revisione e la chiusura dei Psr fino, appunto, all’analisi degli impatti degli interventi e incorporando, in diversi casi, le valutazioni ex ante dei programmi 2014-20.

Un approccio on-going che era stato proposto dalla Ce in continuità e, anche, con grande innovazione, rispetto ai percorsi valutativi realizzati sin dagli anni ’90, sugli interventi relativi agli obiettivi 5a e 5b.

La conclusione del ciclo della valutazione on-going segna, inoltre, il passaggio alla valutazione “durante il periodo della programmazione” 2014-20, caratterizzata da una maggiore attenzione alla conduzione di valutazioni più allineate ai fabbisogni conoscitivi delle amministrazioni e ai programmi.

Questo passaggio ha portato gli autori a condividere alcune riflessioni che prendendo spunto, anche, dai risultati di precedenti attività di ricerca, restituiscono, con questo contributo, una lettura complessiva del sistema di valutazione nel contesto della programmazione per lo sviluppo rurale e, in quest’ambito, dei progressi compiuti nell’evoluzione della “cultura della valutazione”. La prima parte del lavoro sintetizza le novità introdotte con il sistema di valutazione on-going per il periodo di programmazione 2007-13 e le sue principali caratteristiche.

La seconda parte è focalizzata sul processo di capacity building in materia di valutazione osservato nel corso degli anni e che, incoraggiando le organizzazioni a pensare e agire “in modo valutativo”, anche attraverso l’apertura a nuovi utilizzatori, ha certamente favorito l’evoluzione di una maggiore consapevolezza della governance dei processi valutativi.

La terza parte, descrive le modalità con cui diverse amministrazioni regionali hanno dato seguito ai risultati dei percorsi di valutazione on-going e di cui è esemplificativo il caso della learning evaluation applicato alla Relazione di valutazione intermedia (Riv) 2010 del Psr Sicilia 2007-13.

Infine, nell’ultima parte, si illustrano i principali insegnamenti dell’esperienza 2007-13, delineando, in prospettiva, i possibili margini di miglioramento nella restituzione di evidenze valutative sempre più utili alle esigenze delle amministrazioni, dei valutatori e degli altri stakeholder dei Psr.

La valutazione on-going delle politiche di sviluppo rurale nel periodo 2007-13

I regolamenti sullo sviluppo rurale 2007-13 hanno impresso, rispetto al passato, un impulso rilevante al cambiamento degli approcci alla valutazione delle politiche di sviluppo rurale in termini, tra l’altro, di rafforzamento, omogeneità e sistematicità dei processi.

Il Reg. (CE) n. 1698/20051 sul sostegno allo sviluppo rurale da parte del Fondo Europeo Agricolo per lo Sviluppo Rurale (Feasr) ha compreso l’insieme dei riferimenti metodologici che hanno costituito il Manuale del Quadro Comune per il Monitoraggio e la Valutazione (Qcmv)2

La Nota di orientamento B - Linee guida per la valutazione (Commissione europea, 2006b) del Qcmv, in particolare, ha definito la valutazione come quel processo che «include tutte le attività di valutazione da effettuarsi nell’intero periodo di programmazione, comprese le valutazioni ex ante, intermedia ed ex post». Tale definizione si è posta senz’altro in continuità con le prescrizioni in materia di monitoraggio e valutazione relative ai precedenti periodi di programmazione. Al tempo stesso, l’approccio on-going è stato innovativo, per la sua continuità, nel corso dell’attuazione dei Psr, ha conferito strategicità alle attività di monitoraggio e di valutazione, sottolineando la possibilità e la necessità di attivare eventuali modifiche nell’organizzazione della valutazione. Lo scopo è stato di supportare la definizione e l’implementazione dei Psr, fornendo alle rispettive Autorità di Gestione (Adg) elementi utili e utilizzabili alla comprensione e all’analisi dei risultati raggiunti e degli impatti nel lungo termine, dei fattori di successo e di insuccesso, e delle opportunità di miglioramento. Infatti, la valutazione ha inteso favorire lo sviluppo di una buona politica, contribuendo al miglioramento dell’efficienza e dell’efficacia dei Programmi (Bolli et al., 2010).

Appaiono, dunque, evidenti gli stimoli a considerare un approccio nuovo alla valutazione, non più indirizzato solo all’accountability, ma soprattutto al suo utilizzo. Tale affermazione, tra l’altro, viene consolidata con l’approccio alla valutazione durante il periodo di programmazione (Cristiano, Licciardo, 2016) previsto per il 2014-20. In ogni caso, il ciclo di valutazione on-going di fatto contribuisce a far maturare alle Adg una importante capacità di gestione dei processi valutativi e di confronto con i valutatori.

Nella figura 1 è riportata la schematizzazione indicata dal Qcmv che illustra come la valutazione on-going, oltre a concorrere ad alimentare i momenti obbligatori di valutazione (vale a dire i rapporti ex ante, intermedio ed ex post), accompagna l’intero ciclo di programmazione nelle sue fasi tipiche e ricorsive: programmazione, implementazione, riprogrammazione (eventuale), conclusione.

Figura 1 - Attività, fasi, prodotti e obiettivi della valutazione in itinere, intermedia ed ex post

Fonte: nostre elaborazioni su Nota di orientamento B - Linee guida per la valutazione, Commissione europea, 2006b

Il processo di capacity building nella valutazione dello sviluppo rurale

Nel contesto dello sviluppo rurale, la regolamentazione comunitaria ha imposto sostanzialmente una serie di obblighi in materia di monitoraggio e valutazione, quasi a delineare un quadro rigido in capo agli Stati membri (Sm). In particolare, come rilevato da alcuni autori (tra gli altri, Dwyer et al., 2008; ÖIR, op. cit.; D’Angelillo, 2013; Cristiano et al., 2013; Vidueira et al., 2014; Cristiano, Licciardo, 2016), l’analiticità del Qcmv è stata troppo vincolante, limitando le opportunità di espressione di specificità organizzative, gestionali e tecnico metodologiche; di contro, l’approccio on-going, ha sicuramente rappresentato un impulso alla maturazione della cultura della valutazione. Nel corso dei diversi cicli di programmazione, parallelamente al rafforzamento del ruolo della valutazione per la definizione e l’implementazione dei programmi, si è assistito ad un processo di consolidamento della capacity building delle amministrazioni nella valutazione dello sviluppo rurale, specialmente in termini di formulazione di una propria domanda di valutazione, di confronto in materia di valutazione, di apprendimento e di capacità di (ri)orientare la propria azione.

Nello specifico, il processo di capacity building delle Adg dei Psr è stato promosso dalla Ue sin dalla valutazione degli interventi relativi agli obiettivi 5a e 5b e poi ancora, fino all’attuale periodo di programmazione 2014-20 (Cagliero, Cristiano, 2016).

Da una parte l’emanazione di norme regolamentari e orientamenti, pur ispirati ad un principio di rendicontazione, ha fornito indirizzi su importanti elementi di gestione della valutazione: costruzione della domanda di valutazione, relazione con i valutatori, qualità e utilità delle valutazioni. Con l’istituzione del Qcmv, la Ce ha teso inoltre a definire un quadro europeo comune, omogeneo e robusto per la realizzazione delle valutazioni, che ha favorito il confronto e la discussione sulle esperienze degli Sm attraverso l’istituzionalizzazione e il consolidamento del principio di networking per lo scambio di competenze e di esperienze.

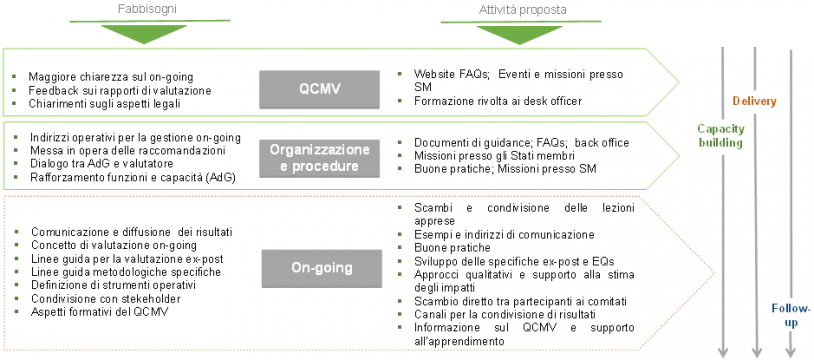

Dall’altra parte, l’istituzione della Rete Europea per la Valutazione dello Sviluppo Rurale3 (art. 86 del Reg. (CE) n. 1698/2005) ha favorito proprio lo scambio di competenze e l’attuazione del supporto e della valutazione della politica di sviluppo rurale. Il lavoro della Rete Europea per la Valutazione si è incentrato sul rafforzamento delle capacità nell’attuazione dei processi di valutazione, attraverso l’organizzazione di attività di workshop tematici e scambi di esperienze, la diffusione di buone pratiche e la redazione concertata di documenti di orientamento o di approfondimento, a partire da una rilevazione dei fabbisogni degli Sm in termini di valutazione (Figura 2).

Figura 2 - Identificazione di principali fabbisogni di valutazione (esclusi quelli puntuali sui dati)

Fonte: nostre elaborazioni su dati European Evaluation Network for Rural Development, 2008 e 2011

All’interno della Rete, è istituito il Comitato degli Esperti Europei della Valutazione, composto da rappresentanti di ogni autorità nazionale competente. All’interno di questo Comitato sono state discusse le questioni inerenti all’applicazione degli obblighi in materia di valutazione, sin dall’esperienza della programmazione 2000-2006 e fino alla definizione di quelli vigenti.

A livello nazionale, nell’ambito del Programma della Rete Rurale Nazionale (Rrn), le attività della Task force Monitoraggio e Valutazione, si sono orientante a favorire il confronto e l’apprendimento condiviso fra tutti i soggetti portatori di interesse nel campo della valutazione dello sviluppo rurale, sia come responsabili che come utilizzatori (Mipaaf, Adg dei Psr, membri del partenariato, rappresentanti di altri Sm, Ue, valutatori, ricercatori, Associazione Italiana di valutazione).

La Ue ha altresì teso a rafforzare le capacità di organizzazione e governance della valutazione, con l’introduzione di indirizzi in materia di strutture di gestione e presidio della qualità dei processi valutativi (steering group) e dell’obbligo di effettuare la valutazione durante la realizzazione dei programmi (valutazione on-going).

Come riportato nella tabella 1, le strutture di governance proposte nella valutazione on-going hanno svolto funzioni che spaziavano dalla stesura delle specifiche tecniche degli affidamenti, alla gestione amministrativa (verifica della conformità dei servizi e dei prodotti realizzati), al supporto metodologico (approcci, metodi e strumenti di valutazione; diffusione e follow-up dei risultati della valutazione), alla facilitazione dei rapporti con i fornitori dei dati (uffici statistici, organismo pagatore) e con i valutatori. Garantendo il confronto sistematico tra gli stakeholder, tale organizzazione ha contribuito a specificare una domanda di valutazione che, nel corso della programmazione, è stata ulteriormente esplicitata in una apprezzabile numerosità di valutazioni tematiche.

Tabella 1 - Ruolo e funzioni delle principali strutture di governance nella valutazione dello sviluppo rurale

Fonte: nostre elaborazioni su Bolli et al., 2010

L’aspetto organizzativo è stato riflesso in processi partecipativi di formulazione della domanda valutativa, che ha, in diverse regioni, coinvolto i soggetti impegnati nella programmazione e le diverse categorie di stakeholder. Questo ha fatto sì che la domanda fosse espressa, via via nel corso della programmazione, in maniera sempre più autonoma e aggiuntiva, rispetto alle prescrizioni di accountability previste dal Qcmv, riflettendo la reale esigenza di approfondimento per i singoli programmi (Cristiano, Licciardo, 2016).

A tal proposito, è possibile affermare che il principale merito della valutazione on-going è quello di aver aperto la strada ad un approccio maggiormente flessibile, guidato dai regolamenti e dal Qcmv, ma soprattutto da una domanda consapevole di valutazione. Questa ha rappresentato l’insieme delle priorità e attività che dovranno essere assunte e, quindi, degli aspetti che dovranno essere oggetto delle analisi del valutatore e rispetto ai quali si dovranno formulare delle risposte. Come indicato da Cristiano et al. (2013), la specificità della domanda valutativa, e le revisioni a cui è stata sottoposta nel corso del settennio di programmazione sulla scorta delle specifiche esigenze emerse, «testimoniano la maggiore consapevolezza acquisita dalle Amministrazioni regionali nel “ritorno di conoscenza” atteso dalla valutazione on-going».

Lezioni di follow-up dai Psr italiani: il caso studio del Psr Sicilia 2007-2013

Nel contesto della valutazione durante il periodo di programmazione, il sostegno della Ce all’utilizzo dei risultati della valutazione è rafforzato, fino a prevedere che «ogni valutazione sia soggetta ad appropriato follow-up conformemente alle norme specifiche di ciascun fondo»4.

Tuttavia, le linee guida comunitarie per la programmazione 2014-20 non forniscono alcuna indicazione, né pratica né teorica, su come dare seguito alle valutazioni dei Psr.

In letteratura, soprattutto nell’ultimo decennio e principalmente a livello internazionale, si sono affermati approcci valutativi specificamente orientati agli usi e all’utilizzazione delle valutazioni (Patton, 2010). Su queste basi sono stati, anche, sperimentati percorsi di follow-up, più o meno organizzati, principalmente orientati alla partecipazione e all’apprendimento, e focalizzati sul miglioramento delle attività di comunicazione e rappresentazione dei risultati delle valutazioni e/o del programma, e sul consolidamento delle capacità di gestione di chi ne è responsabile per l’attuazione.

Una condizione fondante di tali approcci è, evidentemente, la consapevolezza del mandato valutativo e la volontà, condivisa a più livelli, delle amministrazioni circa gli usi e i possibili utilizzi delle valutazioni.

A questo riguardo, nel corso del periodo di programmazione 2007-13, è stato possibile osservare la maturazione di tale consapevolezza, nella manifestazione di un crescente fabbisogno delle amministrazioni regionali di (re)indirizzare l’utilità delle valutazioni on-going, dalle risposte formali al Qcmv alla propria domanda di valutazione. Tale fabbisogno è stato sistematicamente oggetto di confronto con i valutatori indipendenti5, e ha investito le fasi di strutturazione, osservazione, analisi e giudizio dei processi valutativi dei Psr (Commissione europea, 2006a).

A questo proposito, la Rrn ha, anche, realizzato giornate di riflessione e approfondimento in materia di usi e utilità delle valutazioni per finalità di miglioramento dei programmi e della loro attuazione, promuovendo approcci che favorissero l’apprendimento continuo (learning evaluation), e la definizione di una domanda specifica di valutazione, che fosse più utile alle parti interessate, e l’utilizzo dei risultati dei processi valutativi regionali6.

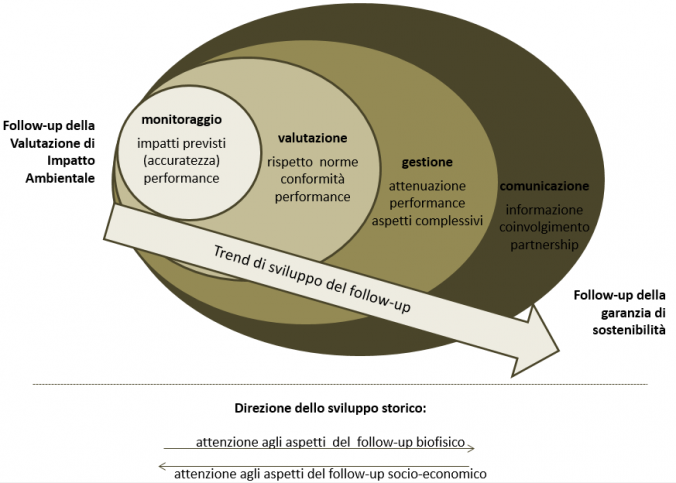

Un approfondimento sulle esperienze applicative di follow-up realizzate in Italia è stato curato dalla Rrn nell’ambito dell’analisi della trattazione delle raccomandazioni presentate dal Valutatore indipendente (Vi) del Psr Sicilia 2007-13 nella Riv al 2010. A seguito della consegna della Riv, nel rapporto dialettico tra esecutore del contratto e committente erano intervenuti anche i Servizi della Ce, con proprie osservazioni rivolte in parte al Vi (es. invito a migliorare l’attività di raccolta dei dati e le metodologie applicate) ed in parte all’Adg (es. migliorare la fornitura dei dati al valutatore e l’applicazione dei criteri di selezione delle domande di aiuto da parte dei beneficiari del Psr). Sebbene in letteratura fosse ampiamente affrontato il tema dell’uso e dell’utilità delle valutazioni delle politiche/programmi (Weiss, 1998; Stame, 2007), l’esigenza di dare formale riscontro a queste osservazioni, a partire dalle analisi sulle cause che le hanno determinate sino alla formulazione di proposte risolutive, ha indotto l’Adg a trarre fondamento metodologico da processi già standardizzati come le Valutazioni d’impatto ambientale (Via) e le Valutazioni ambientali strategiche (Vas) (Morrison-Saunders e Arts, 2005) (cfr. figura 3). Da questi scaturivano esempi di utilizzo dei risultati valutativi quali: le remedial management action, la preparazione di un piano strategico di follow-up, il reporting e l’audit.

A tal proposito, Persson e Nilsson (2007) evidenziano come forme di utilizzo per l’apprendimento possono includere la riconferma di convinzioni esistenti, il supporto alla mobilitazione, la comprensione (utilizzo concettuale) e la comunicazione. Secondo altri autori (Partidário e Arts, 2005), il follow-up alle valutazioni, fornendo nuovi input o feed-back ai risultati, può essere utile per il passaggio di testimone da un livello decisionale all’altro. Ciò nel concreto può trovare applicazione in ogni step della programmazione a supporto delle fasi di modifica dei programmi pluriennali di sviluppo oppure per chiudere i processi decisionali o l’intero ciclo della pianificazione.

Figura 3 - L'evoluzione delle tendenze nel follow-up alla Via

Fonte: Morrison-Saunders e Arts, 2005

Tutto il processo si è articolato in una reiterata sequenza di attività di screening-prescription-treatment-feed-back tra le parti. Lo screening ha riguardato l’indagine diagnostica valutativa sull’intero Programma e sui suoi effetti sul contesto (ad esempio sui beneficiari e, laddove possibile, anche sui non beneficiari). La fase della prescription ha avuto come deliverable le raccomandazioni del valutatore indipendente, a loro volta soggette ad una verifica di qualità da parte delle strutture dell’Adg, sotto i profili della pertinenza e della fattibilità. La fase centrale del treatment è stata organizzata secondo il flusso tipico dei sistemi di gestione per la qualità delle organizzazioni, basato sul concetto di processo e sull’approccio del miglioramento continuo, ossia il miglioramento volto a far migliorare in continuo l’organizzazione e/o alla continuità del miglioramento7. In questa fase l’approccio adottato dalla Regione Siciliana ha metodologicamente ripercorso i quattro momenti del ciclo di Deming (Pdca8) (cfr. figura 4).

Figura 4 - Il metodo Pdca o ruota di Deming per il miglioramento continuo dei processi

Fonte: www.iwolm.com

In termini di risultati, tale esperienza ha prodotto un miglioramento dell’assetto organizzativo-istituzionale del Psr, in particolare, nei seguenti ambiti:

- strutturazione e consolidamento di reticoli relazionali inter-istituzionali (community administration);

- sviluppo di conoscenze, abilità relazionali e competenze valutative all’interno dell’Amministrazione;

- rafforzamento dell’empowerment dell’Amministrazione (Lazzari e Gui, 2013).

Ponendosi nell’atteggiamento aperto e riflessivo (Barabaschi, 2006) di una Pubblica Amministrazione in grado di autovalutare il proprio operato, apprendere lezioni dalle esperienze e misurarsi nel conseguimento di nuovi traguardi, la Regione Siciliana ha scelto quindi di migliorare ulteriormente la governance della politica di sviluppo rurale istituzionalizzando le procedure di follow-up nel Piano di valutazione del Psr 2014-20 (Regione Siciliana, 2015).

Osservazioni conclusive

La lettura complessiva del sistema di valutazione dello sviluppo rurale 2007-13 offre, in ottica evolutiva, l’opportunità di trarre insegnamenti dalle lezioni dell’esperienza e di riflettere sulle possibilità di crescita di una cultura valutativa diffusa tra le amministrazioni, i valutatori e gli altri stakeholder dei Psr.

Il periodo di programmazione comunitaria 2007-13 è stato cruciale per l’innalzamento dei livelli delle competenze e delle conoscenze in materia di valutazione dei Psr. Al riguardo, alla Ce si deve riconoscere il ruolo propulsivo che ha avuto attraverso l’obbligatorietà dei suoi dettati in materia di attività e governance complessiva della valutazione. Inoltre, l’approccio on-going ha reso le Adg più consapevoli riguardo alle proprie responsabilità relative alla definizione dei percorsi valutativi, alla conoscenza valutativa che deve alimentare la programmazione e alla revisione dei Psr (Cristiano, Licciardo, 2016).

In generale, si è assistito ad una considerevole crescita della domanda valutativa e soprattutto della rilevanza della valutazione come pratica di miglioramento e di accrescimento delle conoscenze specifiche sia sulle misure che sui processi di attuazione dei programmi (interventi e delivery). La domanda valutativa, espressa dalle Adg, in maniera sempre più specifica nel corso del periodo di programmazione, rappresenta la cartina di tornasole del livello di approfondimento e personalizzazione raggiunto, rispetto alle distintive esigenze di analisi dei programmi. Tale evoluzione, in diversi casi, è andata nel senso di un rafforzamento delle politiche regionali di tipo evidence-based, fondate, appunto, sul ritorno di conoscenza prodotta dalle valutazioni circa i risultati dei diversi e specifici interventi realizzati (Barca, 2009).

Sul piano operativo, il confronto sistematico tra valutatori indipendenti e Amministrazioni ha senz’altro rappresentato una sfida a cui i primi hanno risposto innovando gli approcci e le pratiche valutative. È, inoltre, servito a maturare attitudini di condivisione dei disegni e dei percorsi di valutazione. Il risultato è stato un complessivo rafforzamento della fondatezza dei giudizi valutativi e della loro accettazione da parte delle Amministrazioni. Il percorso evolutivo della valutazione dei Psr si è realmente risolto in un processo di apprendimento continuo sul Programma e sulla sua attuazione (Reg. (UE) n. 1305/2013). Le valutazioni sono meno focalizzate sulla determinazione di giudizi finali sul programma e i suoi effetti, e più dirette a fornire informazioni su ambiti più specifici/strategici per le singole amministrazioni, quali ad esempio, il delivery del Programma, la progettazione integrata, l’innovazione e l’imprenditoria giovanile in agricoltura (Cristiano, Varia, 2016)

Di fronte alle sporadiche riflessioni su come sia possibile integrare un appropriato follow-up nel mainstream dei processi di monitoraggio e valutazione del Psr, vanno messe in risalto quelle pratiche virtuose che, dando seguito alle conclusioni e raccomandazioni dei valutatori, attraverso l’adattamento (o creazione) dei meccanismi di governance e delle procedure amministrative, agiscono direttamente sull’empowerment del contesto organizzativo-istituzionale dell’azione valutata (Brancati, 2001; Cristiano, Varia, 2016).

In questo scenario, vanno peraltro ancora approfonditi gli aspetti metodologici ed organizzativi (combinazioni di strumenti, timing, risorse, divisioni delle responsabilità, funzioni, revisioni delle procedure di programmazione, modifiche del Programma, ecc.) tali da rendere la valutazione nel corso del periodo di programmazione concretamente utile nelle diverse situazioni. Ulteriori sforzi devono quindi essere compiuti nel favorire la comprensione e il confronto multilivello sui possibili usi della valutazione (strumentale, cognitivo), col fine ultimo della evidence-based policy, attraverso un maggiore orientamento delle risorse e dei percorsi valutativi alla restituzione di evidenze più utilizzabili (Patton, 2010).

In prospettiva, considerate le esperienze e le competenze acquisite, è auspicabile che il cambiamento degli indirizzi comunitari possa favorire la definizione di approcci valutativi sempre più orientati alla costruzione di valutazioni su misura (Rossi et al., 1999) e alle specifiche esigenze degli stakeholder dei singoli Psr. In questo senso si pone anche la evidente criticità in merito alla capacità del flusso di valutazione di accompagnare in modo adeguato le esigenze di programmazione, specie in direzione di un utilizzo concreto dei risultati in termini di effetti e impatti. Troppo spesso, infatti, le attività di valutazione risultano slegate dall'andamento della programmazione, come nel caso della fase ex post che arriva in ritardo per la nuova programmazione, e non sempre in grado di fornire prodotti di facile utilizzo da parte delle amministrazioni o di consultazione da parte degli stakeholder (Bolli et al., 2010).

Riferimenti bibliografici

-

Barabaschi B. (2006), Qualità della pubblica amministrazione e sviluppo delle società locali, FrancoAngeli, Milano

-

Barca F. (2009), An Agenda for a Reformed Cohesion Policy: A place-based approach to meeting European Union challenges and expectations, Brussels

-

Bolli M., Fagiani P., Monteleone A. (a cura) (2008), Sistema Nazionale di Monitoraggio e Valutazione delle Politiche di Sviluppo Rurale. Organizzazione della valutazione on-going, Rete Rurale Nazionale, Roma

-

Bolli M., Fagiani P., Monteleone A. (2009), Governare la valutazione di una politica di sviluppo territoriale. Il caso dello sviluppo rurale, Atti del XII Congresso AIV, Cagliari, 26-27-28 Marzo 2009

-

Bolli M., Cristiano S., De Matthaeis S., Fucilli V. (2010), L’organizzazione della valutazione on-going in Italia: lo stato di attuazione, Rrn, Roma

-

Brancati R. (2001) (a cura), Analisi e metodologie per la valutazione delle politiche industriali, FrancoAngeli, Milano

-

Buscemi V. (2010), La valutazione da adempimento ad opportunità: valutare per migliorare e comunicare, Atti del XIII Congresso AIV, Pisa, 25-26 Marzo 2010

-

Cagliero R., Cristiano S. (a cura) (2013), Valutare i programmi di sviluppo rurale: approcci, metodi ed esperienze, Inea, Roma

-

Cagliero R., Cristiano S. (2016), Il processo di capacity building nella valutazione dello sviluppo rurale, Atti del XIX Congresso AIV, Roma, 21-23 Aprile 2016

-

Cerrai S. e Beccastrini S. (2005), Continuando a cambiare. Pratiche riflessive per generare e valorizzare le competenze nelle organizzazioni, Arpat, Firenze

-

Cristiano S., Fucilli V., Monteleone A. (2013), La valutazione della Politica di Sviluppo Rurale. In: Vergani A. (a cura), Prove di valutazione. Libro bianco sulla valutazione in Italia, FrancoAngeli, Milano

-

Cristiano S., Licciardo F. (2016), La valutazione delle politiche di sviluppo rurale nel periodo 2007-2013: una lettura di sintesi dell’esperienza on-going. Atti della XXXVII Conferenza Italiana di Scienze Regionali, Ancona 20-22 settembre 2016

-

Cristiano S., Varia F. (2016), Pubbliche amministrazioni riflessive: Lezioni di follow-up della valutazione dei Psr italiani, Atti del XIX Congresso AIV, Roma, 21-23 Aprile 2016

-

Commissione Europea (2006a), Manuale del Quadro Comune per il Monitoraggio e la Valutazione - Documento di orientamento. Direzione generale dell’Agricoltura e dello sviluppo rurale, Bruxelles

-

Commissione Europea (2006b), Manuale del Quadro Comune per il Monitoraggio e la Valutazione - Documento di orientamento B - Linee guida per la valutazione. Direzione generale dell’Agricoltura e dello sviluppo rurale, Bruxelles

-

D’Angelillo E. (2013), La valutazione della politica di sviluppo rurale e dello sviluppo rurale integrato. In: Marcianò C. (a cura), Governance rurali in Calabria, Centro stampa di Ateneo, Università degli Studi Mediterranea di Reggio Calabria

-

Dwyer J., Bradley D., Hill B. (2008), Towards an enhanced evaluation of European Rural Development policy reflections on United Kingdom experience, Économie rurale, Société Française d'Économie rurale

-

European Evaluation Network for Rural Development (2008), Rural evaluation news, n. 1, November 2011, Brussels

-

European Evaluation Network for Rural Development (2011), Rural evaluation news, n. 7, October 2011, Brussels

-

Lazzari F. e Gui L. (a cura) (2013), Partecipazione e cittadinanza. Il farsi delle politiche sociali nei Piani di zona, FrancoAngeli, Milano

-

Morrison-Saunders A., Arts J. (2005), Learning from experience: emerging trends in environmental impact assessment follow-up, Impact Assessment and Project Appraisal, Issn: 1461-5517 (Print) 1471-5465 (Online) Journal homepage: [link]

-

Öir, Oar, Pan-Igipz, University of Gloucestershire, Ecorys (2012), Synthesis of Mid-Term Evaluations of Rural Development Programmes 2007-2013, Final Report, Vienna

-

Partidário M.R. e Arts J. (2005), Exploring the concept of strategic environmental assessment follow-up, Impact Assessment and Project Appraisal, 23:3, 246-257, DOI: 10.3152/147154605781765481, Impact Assessment and Project Appraisal, Issn: 1461-5517 (Print) 1471-5465 (Online) Journal homepage: [link]

-

Patton M.Q. (2010), Development evaluation: applying complexity concepts to enhance innovation and use. New York, NY: Guilford Press

-

Persson Å., Nilsson M. (2007), Towards a framework for Sea follow-up: theoretical issues and lessons from policy evaluation, Journal of Environmental Assessment Policy and Management Vol. 9, No. 4 (December 2007) pp. 473-496, Imperial College Press

-

Rossi P.H., Lipsey M.W., Freeman H.E. (1999), Evaluation. A systematic approach, Sage Publications, Inc., CA

-

Regione Siciliana (2015), Programma di Sviluppo Rurale 2014-2020, Ver. 1.5

-

Stame N. (2007) (a cura), Classici della valutazione, FrancoAngeli, Milano

-

Vidueira P., Rivera M., Mesa B., Díaz-Puente (2014), Mid-Term impact estimation on evaluations of Rural Development Programs, Elsevier Procedia - Social and Behavioral Sciences, 191, 1596-1600

-

Weiss C.H. (1998), Have We Learned Anything New About the Use of Evaluation?, American Journal of Evaluation, Vol. 19, No. 1.

- 1. Il Regolamento stabilisce, art. 80 (1), che i programmi di sviluppo rurale sono soggetti a valutazione ex ante, intermedia ed ex post e alla valutazione ambientale strategica effettuate da valutatori indipendenti (art. 80 (4)). In particolare, la Valutazione intermedia ed ex post per i Psr sono normate dall’art. 86 che recita: «La valutazione intermedia e la valutazione ex post analizzano il grado di utilizzazione delle risorse, l’efficacia e l’efficienza della programmazione del Feasr, il suo impatto socioeconomico e l’impatto sulle priorità comunitarie. Esse esaminano se sono stati raggiunti gli obiettivi del Programma e tentano di trarre conclusioni utili per la politica di sviluppo rurale. Individuano i fattori che hanno contribuito al successo o all’insuccesso del Programma, tra l’altro sotto il profilo della sostenibilità, e rilevano le buone pratiche.» Come rilevato da alcuni autori - tra gli altri Bolli et al., 2008; Bolli et al., 2009; Buscemi, 2010; Cagliero, Cristiano, 2013 - il Regolamento introduce quindi l’elemento dell’utilità nel processo di valutazione intermedia ed ex post, un profilo che consente di superare quello consolidato dell’obbligatorietà introducendo, al contempo, un orizzonte più alto e strategico, ai fini del coordinamento e del governo della programmazione, ed uno più operativo e concreto, ai fini del controllo della spesa e del perseguimento degli obiettivi prefissati, a cui la CE tiene particolarmente, in quanto cofinanziatore dei Psr.

- 2. Il Qcmv è uno strumento molto articolato composto di una serie di documenti di indirizzo metodologico, che, di fatto, consolida il percorso comunitario già intrapreso a partire dalla programmazione 2000-20006 in cui nei documenti Star VI/8865/99 e Star VI/12004/00 veniva definito un modello comune di valutazione fondato sul Questionario Valutativo Comune, che esprime la domanda valutativa della Ce, i criteri, in base ai quali formulare i giudizi valutativi e gli indicatori, che dovevano dare evidenza e misurazione ai risultati della valutazione (Cagliero, Cristiano, 2016).

, le linee guida, contenenti obiettivi e metodologie che i valutatori sono tenuti a seguire nell’esercizio valutativo (Commissione europea, 2006a). Si è trattato di uno strumento molto articolato, composto da una serie di documenti di indirizzo metodologico, che hanno supportato l’organizzazione e la gestione dei percorsi valutativi (ad esempio, sulla struttura degli indicatori, sulla logica delle misure previste dal regolamento e su come misurarne gli effetti). - 3. A supporto della Ce è altresì previsto un servizio di Helpdesk della valutazione che svolge funzioni fondamentali a favore degli SM: networking, need assessment, capacity building, disseminazione delle pratiche e coordinamento dei lavori di sviluppo di metodologie e strumenti condivisi di valutazione.

- 4. Art. 56 co. 3 del Reg. (UE) n. 1303/2013.

- 5. In tema di affidamento e gestione dei servizi di valutazione, le Adg italiane, diversamente da quelle europee, hanno fatto ricorso, in maniera quasi esclusiva, alla formula del cosiddetto full outsourcing affidando per tutto il periodo di programmazione il servizio di valutazione ad un singolo soggetto.

- 6. Fra le altre azioni si fa riferimento al Ciclo "L'utilizzo efficace dei risultati della valutazione: un percorso di apprendimento" realizzato dalla Rrn (materiali consultabili alla pagina [link]).

- 7. Il miglioramento del Programma è stato inteso secondo il concetto di qualità statica («fare sempre meglio ciò che si è sempre fatto») e di qualità dinamica («capire quando occorre smettere di fare ciò che si è sempre fatto e fare, man mano sempre meglio, cose nuove e socialmente più utili e professionalmente più etiche») (Cerrai, Beccastrini, 2005).

- 8. Come suggerito dalla norma Uni-EN-Iso 9001:2015 “Sistemi di gestione per la qualità - Requisiti”, il Pdca può essere applicato sia al singolo processo sia alla rete di processi.