Introduzione

Il problema della valutazione della ricerca e, in particolare, dei suoi prodotti, si è imposto in sede internazionale, sin dagli anni ottanta, come una questione di crescente importanza, di pari passo con il diffondersi della cultura dell’accreditamento, della valutazione esterna e dell’autovalutazione.

Alla base della sua diffusione vi sono essenzialmente due ragioni. La prima riguarda il controllo sull’efficienza e l’efficacia della spesa per ricerca, che non è possibile se non si dispone di strumenti che, anche imperfettamente, “misurino” la produzione scientifica. La seconda riguarda lo stimolo alla produttività quali-quantitativa della ricerca. Quest’ultimo nel passato, in Italia e in altri paesi, era sostanzialmente affidato alla progressione di carriera, basata su cooptazione tramite concorsi e quindi esclusivamente su un meccanismo di peer-review. Un meccanismo che dipendeva crucialmente dal controllo sociale all’interno delle discipline, in altre parole dall’accordo fra i suoi componenti sui criteri di merito scientifico e dall’impegno reciproco ad adottarli nelle valutazioni concorsuali, pena la perdita di reputazione all’interno del gruppo. Il meccanismo di controllo sociale è però molto più facile da mantenere all’interno di gruppi ristretti, nei quali le interazioni sono molto frequenti; condizione che è man mano venuta meno con l’estendersi del numero dei ricercatori. Di qui la necessità di integrare le peer-review con criteri in qualche misura "oggettivi” e trasparenti, seguendo i criteri della cosiddetta ‘informed peer review’.

Si è poi progressivamente accresciuta la consapevolezza che non andassero valutati esclusivamente i singoli ricercatori di università o istituti di ricerca – a fini di reclutamento e/o di progressione di carriera - ma anche le performance complessive di gruppi di ricerca omogenei, di dipartimenti (o altre unità analoghe chiaramente identificabili anche in termini di risorse finanziarie e strutturali) di università e centri di ricerca. In generale, tali valutazioni – sia che siano effettuate autonomamente da una struttura, sia che siano commissionate da istituzioni esterne, spesso pubbliche – non sono meri strumenti di controllo, finalizzati alla formulazione di un giudizio sull’efficienza ed efficacia della spesa per ricerca, ma mirano, appunto, a stimolare il miglioramento della produttività quanti-qualitativa della ricerca e, più in generale, della reputazione pubblica dell’istituzione di ricerca.

Pur essendo partita con ritardo rispetto ad altri paesi, l’Italia non è estranea a questo processo, che, a livello nazionale, si è avviato con l’esercizio di Valutazione triennale della ricerca (Vtr) 2001-2003 del Comitato di indirizzo per la valutazione della ricerca (Civr) ed è proseguito con il Valutazione della qualità della ricerca (Vqr) promosso da Agenzia nazionale di valutazione del sistema universitario e della ricerca (Anvur) per il periodo 2004-2010 e in corso di realizzazione, mentre, su scala più ridotta, sono da ricordare alcune esperienze autonomamente promosse da taluni atenei e istituti di ricerca italiani.

Questo lavoro si prefigge di discutere brevemente gli approcci adottati in alcune esperienze di valutazione della produzione scientifica realizzate a livello internazionale, con particolare riferimento alle questioni inerenti alle metodologie basate su peer-review dei lavori e su indicatori bibliometrici, e di presentare i risultati di un esercizio di misura della produzione scientifica degli economisti agrari italiani raccolti nel Settore scientifico disciplinare AGR/01 sulla base di alcuni indicatori bibliometrici. L’articolo trae, infine, alcune conclusioni sulla base dei risultati emersi, soprattutto in termini di indicazioni per il futuro.

La valutazione della produzione scientifica: peer-review e metodi bibliometrici

Fin dalla metà degli anni ottanta, singole istituzioni di ricerca, loro aggregazioni, o interi Paesi hanno sviluppato esperienze di valutazione basate su procedure ben definite, che hanno cercato di conciliare:

- le esigenza di rigore, di oggettività della valutazione e di applicabilità in aree di ricerca molto diverse - per contenuti, approccio alla ricerca, “velocità di obsolescenza” nelle conoscenze acquisite, stile editoriale, ecc. - con l’intrinseca difficoltà di misurare il progredire del sapere;

- i costi diretti e indiretti – spesso rilevanti – degli esercizi valutativi con i benefici attesi in termini di attivazione di meccanismi virtuosi finalizzati ad una migliore qualificazione della ricerca (Hicks, 2008).

Gli approcci valutativi utilizzati variano, in generale, a seconda:

- di chi si intende valutare (progetti, singoli ricercatori, gruppi di ricerca, dipartimenti, università, ecc.);

- dell’oggetto della ricerca (la produzione scientifica tout court o quella di eccellenza);

- delle finalità della valutazione (carriere individuali, controllo ex post o decisioni in merito alla erogazione di fondi, accreditamento di una struttura di ricerca, comunicazione al largo pubblico della reputazione, creazione di ranking internazionali, ecc.);

- di chi sono i destinatari e gli utilizzatori finali dei risultati della valutazione (gli stessi ricercatori, l’audit interno della struttura, gli enti finanziatori, le istituzioni, gli studenti e i dottorandi potenziali, l’opinione pubblica, ecc.) (European Commission, 2010).

Questa intrinseca differenziazione negli approcci metodologici si è tradotta in una molteplicità di esperienze concrete: basti pensare, ad un estremo, ai rigorosi esercizi valutativi sulla qualità della ricerca – di cui la qualità della produzione scientifica è uno degli aspetti più salienti – condotti o commissionati da istituzioni governative e che interessano tutte le istituzioni di ricerca di un paese e, all’altro estremo, ai ranking di università basati su insiemi molto sintetici e talora discutibili di indicatori. Rispetto a questi ultimi, si ricordano, ad esempio, il ranking annuale Censis per l’Italia e, a livello internazionale, il World universities ranking on the web di Cybernetics Lab, l’Arwu di Shangai, il Wur del Times, il Cwts di Leiden e la recente iniziativa comunitaria finalizzata alla creazione di un sistema multiranking condiviso delle università dell’Unione Europea (European Commission, 2009; Vught, Ziegele, 2011).

Nonostante le molte esperienze realizzate, tuttavia, non si è ancora giunti a consolidare standard condivisi per ciascuna finalità valutativa e le stesse università o paesi continuano a modificare, in taluni casi radicalmente, i propri sistemi di appraisal.

Per quanto riguarda l’approccio metodologico alla valutazione della produzione scientifica, il dibattito, ancora in corso anche tra gli studiosi dell’argomento, si incentra soprattutto:

- sull’esigenza di contemperare una valutazione di merito sulla qualità di ciascun prodotto della ricerca (research output) basata su peer-review – quindi lunga e costosa e più aperta alla soggettività –, con una, più agevole e spedita, basata su indicatori bibliometrici, quali quelli relativi alla reputazione della collocazione editoriale del lavoro (research outlet) e delle citazioni ricevute da una determinata pubblicazione;

- sulla costruzione, la scelta, il miglioramento degli indicatori bibliometrici, che ne eliminino le distorsioni – soprattutto quando utilizzati per comparazioni tra aree di ricerca diverse – e lo sviluppo di indici specifici per le finalità peculiari di ciascuna tipologia di esercizio valutativo;

- sullo studio di indicatori che si applichino anche ad aree di ricerca con tradizioni editoriali che privilegiano sedi editoriali diverse dalle riviste (monografie, ecc.) e/o oggi assenti o debolmente presenti nei cataloghi internazionali indicizzati;

- sul grado di coinvolgimento della comunità scientifica nel processo valutativo, sia in termini di condivisione dei criteri e dei metodi, che di partecipazione diretta al processo.

In questa sede non c’è lo spazio per un’analisi dettagliata delle dinamiche delle esperienze realizzate in altri Paesi, per un esame delle quali si rimanda alla ricca appendice riportata in un recente studio promosso dalla Commissione Europea (2010); tuttavia giova ricordare come sia in atto una tendenza generalizzata a ricercare un compromesso “ideale”, pur difficile, tra peer-review e indicatori quantitativi, tra cui sono ricompresi quelli bibliometrici (Moed, 2009), che presenti delle differenziazioni tra aree disciplinari in ragione dell’applicabilità o meno di questi ultimi (anche l’esercizio Vqr 2004-2010 di Anvur (2011 a, b) si muove essenzialmente in questa direzione). Ad esempio, il Research Assessment Exercise (Rae) che ha coinvolto nel processo di valutazione tutti i dipartimenti delle università del Regno Unito per sei volte a partire dal 1986, si è essenzialmente incentrato su un processo basato su peer-assessment da parte di panel. Nell’ultima edizione del 2008 vi è stata affiancata una “valutazione sperimentale ombra” basata su indicatori bibliometrici, al fine di verificare la loro applicabilità e affidabilità. Dal 2010 il Rae è stato sostituito da un nuovo sistema di valutazione, più snello e meno costoso, questa volta orientato alla valutazione dell’eccellenza nella ricerca, in cui i sub-panel di determinate aree disciplinari, là dove dispongano di dati citazionali robusti, possono avvalersi anche di indicatori bibliometrici per le proprie valutazioni. Un approccio analogo è adottato nella valutazione della produzione scientifica danese (Danish Agency for Science, 2010) e olandese (Vsnu-Knaw-Now, 2009), in cui il processo prende l’avvio con la redazione di un rapporto di autovalutazione da parte della struttura e si conclude con una replica alla valutazione formulata dai panel. In Italia esperienze analoghe sono state condotte, ad esempio, dall’Università di Padova e da Inea. Per contro, l’esperienza dell’Australia è meno lineare nella sua evoluzione: prende l’avvio nel 1995 con la costruzione di un sistema di ranking delle università basato su parametri quantitativi, in cui il peso di indicatori bibliometrici basati su database commerciali va progressivamente aumentando; dopo l’aborto di un progetto molto più articolato, complesso e costoso in cui avrebbero dovuto essere valutati i singoli gruppi di ricerca (Rfq), nel 2008 viene avviato Era, un processo di valutazione dell’eccellenza della ricerca, articolato per aree disciplinari e basato su indicatori quantitativi e bibliometrici differenziati per aree. Dell’esercizio Era sembra interessante segnalare la costruzione di un sistema di rating (A, B, C, D), specifico per aree disciplinari, della reputazione della collocazione editoriale dei lavori scientifici. Esso interessa sia le aree di ricerca meglio rappresentate nei database commerciali Isi e Scopus, sia quelle meno presenti o del tutto assenti, quali talune delle humanities. Nel primo caso, il rating è elaborato sulla base della distribuzione in quartili di indici di impatto normalizzati per area, nel secondo sulla scorta di classificazioni elaborate e validate dalla comunità scientifica e da panel di esperti. Era ha tentato un analogo rating delle sedi editoriali delle monografie, che tuttavia è stato ritirato dopo le proteste delle case editrici. Classificazioni analoghe sono sviluppate, a supporto dei panel, nell’ambito dell’esercizio valutativo quadriennale Aeres per la Francia, nel caso spagnolo (Cruz-Castro, Sanz-Menéndez, 2006) e, autonomamente, in altre università europee.

Nel caso della valutazione individuale di singoli ricercatori, sembra utile ricordare che l’uso esclusivo di indicatori bibliometrici è generalmente limitato alla definizione di requisiti minimi per l’accesso alla valutazione (si pensi alla valutazione per sessenni spagnola o al caso francese, che stabiliscono un numero minimo di pubblicazioni quotate con un prefissato rating, variabile da area ad area), mentre la valutazione di merito da parte di panel si basa su peer-review suffragata da indicatori quantitativi. Il recente DM 14 settembre 2011 sulla abilitazione scientifica nazionale per l’accesso al ruolo dei professori universitari, in vigore dal 31 gennaio 2012, sembra ricalcare questo solco.

Per quanto imperfetti e discutibili, gli indicatori quantitativi di produttività quanti-qualitativa della ricerca giocano dunque un ruolo progressivamente crescente, anche se complementare alla peer-review, nei processi di valutazione della ricerca, anche perché consentono comparazioni nazionali e internazionali tra gruppi omogenei dal punto di vista disciplinare. La ricerca sta progressivamente affinando gli indicatori bibliometrici per eliminare distorsioni − dovute, ad esempio, alla diversa numerosità delle comunità scientifiche (normalizzazione degli indici entro ciascuna sub-area), alla distribuzione di frequenza delle citazioni dei lavori di uno stesso autore e alle autocitazioni − ed ha stabilito dei criteri per un uso appropriato. Tra questi si ricordano, per i valutati: conoscenza a priori degli indicatori utilizzati in una valutazione, possibilità di verificare l’accuratezza delle informazioni bibliografiche utilizzate e di fornire informazioni supplementari; per tutti i soggetti coinvolti: consapevolezza della portata, delle potenzialità e dei limiti di ciascun indicatore, chiarezza del contesto valutativo, uso degli indicatori come segnali di taluni aspetti quanti-qualitativi piuttosto che come termini da inserire in algoritmi che generano automaticamente il risultato della valutazione (Moed, 2005).

Sono invece più difficili i confronti tra “saperi” distanti tra loro quanto a:

- differenze nelle pratiche di pubblicazione (riviste vs. monografie) e di citazione (si pensi che un Impact Factor pari ad 1 è considerato mediamente buono per la matematica o per molte scienze sociali e bassissimo per l’area chimica);

- numero di autori per pubblicazione;

- diversa gerarchia nelle sedi editoriali;

- “oggetto” della ricerca e possibilità/incentivo a pubblicare in sedi internazionali;

- lingua veicolare prevalente (si pensi ad alcuni ambiti giuridici);

- diversa velocità nel procedere della conoscenza, intervallo di tempo per il raggiungimento dell’obsolescenza di un determinato risultato e conseguente riflesso sulle possibili citazioni;

- diverso peso delle mission in ricerca strategica, regionale e in campi applicativi specifici (Commissione Europea, 2010).

Come noto, la diffusione dell’impiego di indicatori bibliometrici nella valutazione della produzione scientifica è anche direttamente correlata al progressivo miglioramento del grado di copertura della produzione scientifica delle diverse aree disciplinari − sia come ambiti che, in misura minore, come tipo di sede editoriale – da parte dei database citazionali commerciali (Isi-Web of Science di Thomson Reuters e, dal 2004, Scopus di Elsevier) e di quelli open access, quali Publish or Perish, che indicizza quanto compare in Google Scholar, il motore di ricerca che opera solo su siti accademici e di istituzioni di ricerca (Harzing, 2007). Nonostante i continui e notevoli progressi, tuttavia, il grado di copertura delle diverse discipline è ancora piuttosto diverso e appena agli inizi per quanto riguarda le monografie e altri output diversi dagli articoli su rivista. Per quanto riguarda i due database commerciali, essi producono risultati sostanzialmente sovrapponibili solo in alcuni ambiti delle “scienze dure”, e per questo motivo si tende ad utilizzare entrambi nelle valutazioni. Publish or Perish, meno usato dei precedenti, ha il vantaggio di indicizzare anche la “letteratura grigia”, ma con ampi margini di errore legati alla fonte utilizzata. Tutti i database infine hanno dei problemi relativi a omonimie e a errori grammaticali nella scrittura appropriata dei nomi degli autori, per cui è preferibile fare esercizi di valutazione su liste di lavori validate, per costruzione o ex-post, dagli autori stessi. L’esercizio presentato nel prossimo paragrafo utilizza alcuni indicatori disponibili su tutti i tre database; tuttavia i dati ottenuti non sono stati sottoposti a validazione da parte degli autori (per esempio, le omonimie sono state eliminate direttamente sulla base dell’argomento della pubblicazione) e, quindi, i risultati vanno interpretati con cautela e come puramente indicativi.

Sembra utile riprendere integralmente, infine, i principi base ai quali dovrebbe ispirarsi l’uso di indicatori in qualunque esercizio di valutazione della ricerca universitaria, secondo lo studio promosso dalla Commissione Europea (2010) più volte richiamato. Si tratta di richiami che non intendono respingere il loro utilizzo, ma delineare i confini di un loro corretto impiego:

- non c’è un solo insieme di indicatori in grado di cogliere la complessità della ricerca e della sua valutazione;

- non esiste un indicatore perfetto; quelli proposti hanno punti di forza e di debolezza che vanno considerati;

- non esiste un indicatore oggettivo, in quanto sono raramente misure dirette ma proxy;

- gli indicatori debbono essere calibrati per l’obiettivo specifico e verificabili;

- i differenti stili di pubblicazione e diffusione dei risultati dei diversi ambiti disciplinari possono essere favoriti o svantaggiati dalla scelta di determinati indicatori, compresi gli indici bibliometrici, e di questo occorre tenere conto;

- la scelta, la ponderazione e l’interpretazione degli indicatori è dunque un aspetto molto rilevante di un esercizio valutativo.

L’esercizio bibliometrico sulla produzione scientifica degli economisti agrari italiani

Presentiamo qui i risultati di un’analisi degli indici bibliometrici più diffusi riguardante i docenti e ricercatori del settore economico-agrario (Agr/01). Riguarda, nello specifico:

- il numero di articoli, e le citazioni da essi ricevute, deducibili dalla banca dati ISI-Web of knowledge, che include le riviste che dispongono dell’Impact Factor;

- il numero di articoli, le citazioni ricevute, e l’indice h derivanti dalla banca dati Scopus (elaborata dalla casa editrice Elsevier);

- il numero di lavori, le citazioni ricevute da questi, gli indici h e g derivanti da Publish or Perish (PoP)1.

Il numero di articoli ISI o Scopus misura in un certo grado la produzione su riviste più citate internazionalmente in un determinato ambito disciplinare (l’assunto nell’ambito della bibliometria è che le citazioni siano una proxy della loro qualificazione, anche se il loro prestigio può molto variare). Il numero di citazioni ricevute dagli autori è un indicatore, sia pure imperfetto, dell’importanza del contributo scientifico. L’indice h cerca di tenere conto contemporaneamente sia della quantità (numero di lavori pubblicati) sia della notorietà, cioè del numero di citazioni ricevute, in altre parole è un indicatore dell’impatto di un ricercatore; più precisamente un ricercatore ha indice 3, ad esempio, se almeno tre suoi lavori hanno avuto almeno tre citazioni. L’indice g è analogo nello spirito, ma indica come livello g il numero di articoli, elencati in ordine decrescente di citazioni ricevute, che hanno complessivamente ricevuto g2 citazioni. La ricerca dei dati ha interessato il periodo dal 2004 a tutt’oggi2, che è analogo a quello utilizzato dall’Anvur (che peraltro si fermerà al 2010)3. Non abbiamo preso in considerazione l’Impact Factor ISI-Web of Science delle riviste sulle quali sono collocate le pubblicazioni, né gli analoghi indicatori sviluppati su Scopus, ma solo il numero di quelle incluse nelle tre banche dati e le relative citazioni: le pubblicazioni non sono quindi pesate in base al prestigio della sede di pubblicazione in un dato ambito (misurato sulla base delle citazioni complessivamente ricevute dalla rivista). Questa è una rilevante semplificazione rispetto all’esercizio Vqr Anvur, che, a quanto emerge dal bando, terrà conto anche del fattore di impatto tra gli indicatori bibliometrici. Come noto, inoltre l’esercizio Vqr non considera PoP.

Innanzitutto, gli economisti agrari italiani non sono in media molto presenti nelle riviste usualmente prese in considerazione per la valutazione. Complessivamente, il settore comprende 311 persone, di cui 87 professori ordinari (PO), 112 professori associati (PA), 91 ricercatori confermati (RU) e 21 ricercatori non confermati RUnc). Su questo totale, il numero complessivo di articoli su riviste Isi su tutto il periodo è di 299, con una media per persona di meno di un articolo (0,98) e di 3,1 citazioni ricevute. Per la banca dati Scopus, che comprende un numero maggiore di riviste, il totale è 456, la media 1,5 articoli e 4 citazioni. Infine PoP, che comprende anche comunicazioni a conferenze, working paper, volumi, e in generale quindi anche la “letteratura grigia”, riporta una somma di 2973 documenti, pari a 9,6 documenti e 20,5 citazioni per persona. Comunque la si consideri, appare evidente che la presenza degli economisti agrari italiani su queste banche dati è piuttosto ridotta. Ci sono ovviamente differenze fra le diverse fasce. Per quanto riguarda Isi, i valori medi di articoli e citazioni dei PA sono maggiori di quelli dei RU, seguiti dai PO per quanto riguarda le citazioni, dai RUnc per il numero di articoli (Tabella 1); i valori medi di articoli e citazioni Scopus sono, in ordine decrescente, quelli relativi ai PA, ai RU, ai RUnc, e ai PO; viceversa per PoP la graduatoria dei valori medi segue l’ordine “naturale”, vedendo in testa i PO. Una spiegazione – parziale- che si può tentare a questo proposito è che esista un effetto culturale di coorte. Nel passato, nella considerazione comune degli appartenenti alla disciplina, pubblicare sulle riviste internazionali (quelle comprese in Isi e Scopus) non era considerato una condizione necessaria perché il proprio lavoro scientifico venisse apprezzato, mentre esistevano molte sedi editoriali nazionali (alcune delle quali compaiono in PoP), il che rifletteva peraltro un dibattito scientifico poco aperto verso l’esterno. E’ quindi naturale che le generazioni (e le fasce) più giovani siano più orientate verso le pubblicazioni che ora sono considerate espressione di un dibattito internazionalizzato. Si tratta di un’ipotesi che andrebbe comunque verificata mettendo in relazione la produzione scientifica degli appartenenti alle diverse fasce con l’anzianità anagrafica e di ruolo, cosa che i dati non permettono4. Va inoltre notato che solo recentemente la legislazione italiana ha introdotto nella regolamentazione dei concorsi l’obbligo di tener conto degli indici bibliometrici; l’incentivo alla produzione scientifica di quel tipo ai fini della carriera è stato quindi lungamente assente, in quanto ha stentato ad essere adottato come criterio diffuso nella pratica delle commissioni di concorso. I dati relativi alle scarse differenze di produttività scientifica media fra fasce sembrano suggerire che i criteri di selezione e di progressione di carriera finora utilizzati non sono stati mediamente in coerenza con l’obiettivo di favorire l’impegno del personale universitario a pubblicare su questo tipo di riviste.

La percentuale di coloro che hanno pubblicato almeno un articolo Isi è il 40,7% del totale (36,8% degli ordinari, 61,1% degli associati, 42,9% dei ricercatori confermati), percentuale che sale al 50,6% per gli articoli Scopus (42,3%, 50,9% e 50,5% per le tre fasce) e all’88,5% per PoP (88,5%, 91,1%, 84,6% rispettivamente). Ovviamente, le percentuali di coloro che hanno ricevuto citazioni è minore, perché alcuni lavori non ne hanno ricevuta nessuna.

Di particolare interesse è poi il valore delle mediane degli indicatori: l’Anvur (2011 a, b), infatti, ha proposto di condizionare l’accesso alla procedura di abilitazione nazionale al superamento della mediana della fascia a cui i candidati aspirano. Per i PO la mediana è 0 sia per gli articoli Isi sia per quelli Scopus (e ovviamente lo stesso vale per le citazioni e per l’indice h); per i PA, i RU ed i RUnc la mediana è 0 per i prodotti e le citazioni Isi, 1 articolo e 0 citazioni Scopus, e indice h pari a 0. I dati evidenziati appena sopra mostrano dunque come una frazione importante degli attuali docenti e ricercatori potrebbe, a breve e se la situazione non cambierà, essere esclusa dalle procedure di abilitazione, sia come candidati, sia come commissari. In qualche modo paradossalmente, inoltre, e sia pure per una differenza molto piccola, se fosse applicata la proposta Anvur chi aspira ad un posto da associato deve avere una maggior produzione di chi aspira a quello di ordinario.

Tabella 1 - Indici bibliometrici degli appartenenti al Settore Scientifico Disciplinare AGR/01 (311 oss.; 87 PO, 112 PA, 91 RU, 21 RUnc)

Più in generale, la produzione appare scarsamente correlata con la posizione accademica: non solo esistono ricercatori di fascia più bassa con maggior produzione scientifica di altri in quelle più alte e la variabilità all’interno delle fasce è molto maggiore di quella fra fasce, ma neppure i valori medi mostrano una relazione diretta con la posizione. La produzione scientifica Isi e Scopus, in particolare, non appare correlata con la fascia di appartenenza. I PO, che rappresentano il 28% del totale, coprono il 21,4% degli articoli Isi col 18,4% delle citazioni, il 23,7% dei lavori Scopus col 21,8% delle citazioni, ma arrivano al 42,1% dei paper PoP, col 33,5% delle relative citazioni. Per i PA, (36% del raggruppamento disciplinare), le cifre sono 41,8 e 44,5% per Isi, 38,6 e 42,3% per Scopus, e 31,2 e 35,1% per PoP. I ricercatori confermati (29,3% del totale) hanno il 32,1% dei lavori Isi e il 30,8% delle relative citazioni, il 31,1% degli articoli Scopus e il 29% delle citazioni, il 22,1% dei paper PoP con il 26,7% delle citazioni.

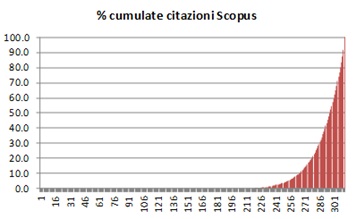

Un secondo tipo di risultato dell’analisi è la fortissima variabilità individuale della produzione. Senza utilizzare indicatori statistici più elaborati, basti osservare il campo di variazione degli indicatori, che vanno da 0 (valore minimo per tutti gli indicatori) a 19 paper e 102 citazioni Isi, a 19 paper e 104 citazioni Scopus, a 273 paper e 345 citazioni PoP. Inoltre, dato forse più importante, la produzione censita è fortemente concentrata. Come si può notare dal grafico 1, l’ultimo 10% dei docenti e ricercatori (31 persone) copre il 52% degli articoli Isi e il 46% di quelli Scopus, e le corrispondenti percentuali per le citazioni sono 90% e 74% (si noti tuttavia che non si tratta necessariamente delle stesse persone). I documenti Publish or Perish mostrano una distribuzione meno concentrata, ma tuttavia il decile superiore copre il 43% dei paper ed il 59% delle citazioni. Come si può notare anche dai grafici, la distribuzione delle citazioni è più concentrata di quella dei lavori. Differenziando per fascia, emerge che la produzione è maggiormente concentrata nella fascia degli associati, dove il decile di punta (9 unità) copre il 55,2%, il 46,6% e il 34,4% degli articoli Isi, Scopus e PoP, rispettivamente, con il 75,4%, il 65,3% ed il 55,8% delle citazioni. Per gli ordinari, le percentuali relative sono 45,3%, 43,5% e 49,2% per i lavori, e 71,2%, 72,9% e 53,8% per le citazioni. Infine per i ricercatori confermati i dati corrispondenti sono 45,8%, 41,5% e 36,2% per i lavori, e 84,8%, 81,3% e 59,8% per le citazioni. Questo risultato evidenzia dunque come vi sia un limitato numero di studiosi molto attivi a livello internazionale e forse da più tempo, e una ampia frazione di altri meno presenti. E’ possibile che fra questi una parte abbia cominciato a presentare lavori su riviste indicizzate più di recente, anche se la nostra analisi non ha potuto verificare questa ipotesi; se questa fosse vera, indicherebbe un punto di debolezza allo stato attuale, ma che potrebbe essere un buon segnale in prospettiva.

Grafico 1 - Percentuali cumulate di alcuni indicatori bibliometrici per il settore AGR/01

Nell’analisi effettuata si è potuto osservare come la produzione scientifica degli economisti agrari che compare su riviste indicizzate abbia natura spesso di carattere interdisciplinare. Per esempio, nel caso di Isi-Web of Science i lavori spaziano anche oltre la categoria JCR “Agricultural Economics and Policy” (che peraltro comprende solo 14 riviste), comparendo in riviste di tipo economico, multidisciplinare o specialistiche di ambito agricolo, alimentare, forestale, ambientale, ecc.. Nel caso di Scopus viene invece adottata una categorizzazione più ampia, che non scende ad un livello di dettaglio in cui l’economia agraria sia una categoria a sé. Questa situazione impone particolare cautela nell’utilizzare gli indicatori bibliometrici: per esempio agli indicatori assoluti sono preferiti, nell’esperienza internazionale, indicatori normalizzati entro l’ambito in cui é collocata la rivista esaminata. L'indicatore relativo così ottenuto consente infatti confronti tra abitudini di pubblicazione diverse. In altre parole, se ad esempio un economista agrario pubblica su una rivista di agronomia con l’Impact Factor 3, questo IF non viene preso tale e quale, ma vale di meno se, ad esempio, il valore medio delle riviste di agronomia è 5.

Considerazioni conclusive

La strada della valutazione della ricerca e, di conseguenza, della qualità della produzione scientifica è un percorso imboccato a livello internazionale e a tutti i livelli di governance, nazionale e di singole università o istituzioni di ricerca. La motivazione principale non è tanto quella di controllare l’operato dei ricercatori, quanto quella di stimolare meccanismi di crescita delle performance della ricerca in termini di qualità dei risultati. Questa strada sembra anche essere stata imboccata con decisione dal legislatore italiano.

Gradualmente, questa cultura della valutazione si sta diffondendo anche nella comunità scientifica, nella consapevolezza che è uno strumento utile per la qualificazione della ricerca stessa e per la partecipazione, su base competitiva, ai processi di reperimento delle risorse. Pur con i loro limiti, gli indicatori quantitativi e, segnatamente quelli bibliometrici, sono strumenti utili da impiegare in affiancamento alla peer-review. Sia per la peer-review, sia per l’uso degli indici bibliometrici, si pone il duplice problema di fornire le indicazioni nella direzione desiderata dal policy-maker (cioè di indicare quale tipo di produzione scientifica si vuole) e di fornire l’opportuno incentivo a comportamenti coerenti con queste indicazioni da parte dei valutatori. E’ quindi importante che i criteri di valutazione siano mantenuti per tempi lunghi – in modo che i ricercatori possano adeguare il loro lavoro – e che gli esercizi di valutazione si mantengano coerentemente e in maniera trasparente a quegli obiettivi evitando conflitti di interesse dei valutatori. I risultati emersi dal piccolo esercizio valutativo effettuato sulla produzione scientifica degli economisti agrari italiani a partire dal 2004, pur con i suoi limiti, ha evidenziato come questa strada sia stata imboccata anche nel nostro ambito disciplinare, sia pure da una frazione ancora limitata, anche se presumibilmente crescente, di ricercatori: il 40% dei colleghi ha pubblicazioni indicizzate su Isi-Web of Science e il 50% su Scopus. In questo momento, la disciplina si trova in una situazione poco soddisfacente e di svantaggio relativo rispetto ad altri settori dell’area Cun “Scienze agrarie e veterinarie”, nella quale molti di essi hanno colto con maggiore anticipo questo segnale, e si presenta accomunata con altri ambiti delle scienze sociali, in cui il processo di indicizzazione delle produzione scientifica –e quello della presa in considerazione degli indici bibliometrici nelle valutazioni concorsuali- è partito con più ritardo.

Il problema che si pone è allora quello di aumentare la produttività del sistema di ricerca, non solo nel settore economico agrario, come sembra confermato dall’introduzione di meccanismi incentivanti che erano invece solo debolmente presenti nel passato. Alla base delle limitate performance, almeno fino ad oggi, del sistema universitario italiano é infatti l’imperfetto funzionamento di meccanismi di questo genere. Le recenti innovazioni legislative obbligano invece ad un cambiamento netto di mentalità, perché sempre di più le persone e le istituzioni saranno premiate in base alla loro produttività scientifica. Oltre che a livello individuale, questo dà ai dipartimenti universitari, che sono diventati l’istituzione decisiva, un forte incentivo a stimolare i propri ricercatori e a reclutarne di nuovi in grado di garantire una produzione scientifica qualificata, tale da assicurare un apporto di fondi e di risorse fisse umane agli stessi Dipartimenti. Questo pone un problema immediato al settore economico-agrario, per il suo svantaggio rispetto a altre discipline di Scienze agrarie e veterinarie, anche se la misura precisa di questo divario richiederebbe un approfondimento comparativo tra settori e nel tempo che esula dagli obbiettivi di questo lavoro. Allo svantaggio congiunturale si può sopperire, in via transitoria − come è avvenuto in altri Paesi per taluni ambiti disciplinari, anche delle scienze sociali, soprattutto applicate − individuando come transitoriamente qualificate ad ottenere un elevato rating un limitato numero di riviste non indicizzate. Tuttavia questo non può costituire un alibi per non perseguire con determinazione e tempestività un percorso virtuoso di miglior qualificazione internazionale dei risultati della nostra attività di ricerca, anche perché i processi di valutazione in atto e i loro esiti attesi costituiscono un forte incentivo in questa direzione.

Siti di riferimento

Riferimenti bibliografici

-

Anvur (2011 a) Criteri e parametri di valutazione dei commissari e dei candidati dell’abilitazione scientifica nazionale, documento approvato dal Consiglio Direttivo il 22 giugno 2011, [pdf]

-

Anvur (2011 b) Sul documento ANVUR relativo ai criteri di abilitazione scientifica nazionale. Commenti, osservazioni critiche e proposte di soluzione, documento approvato dal Consiglio Direttivo il 25 luglio 2011, [pdf]

-

Cruz-Castro L., Sanz-Menéndez L. (2006), Research evaluation in transition: individual versus organisational assessment in Spain, Unidad de politica comparada, Working paper 06-12, Consejo Superior de Investigaciones Científicas (CSIC), pp.25

-

European Commission (2009), Feasibility Study for Creating a European University Data Collection, Contract No. RTD/C/C4/2009/0233402 Final Study Report, Directorate general for the research, Bruxelles, pp. 256

-

European Commission (2010), Assessing Europe’s University-based Research, Expert group on assessment of University-based research, Directorate general for the research, Communication unit, Bruxelles, pp.148

-

Danish Agency for Science (2010), Research evaluation guidelines, http://en.fi.dk

-

Harzing, A.W. (2007) Publish or Perish, http://www.harzing.com

-

Hicks D. (2008), Evolving regimes of multi-university evaluation, Georgia Tech-Ivan Allen College working paper series, 27, pp.15.

-

Moed H.F. (2005), Citation analysis in research evaluation, Springer Verlag, Heidelberg, pp. 347

-

Moed H.F. (2009), “New developments in the use of citation analysis in research evaluation”, Scientometrics, 57, pp.13-18.

-

VSNU-KNAW-NWO (2009) Standard evaluation protocol 2009-2015: Protocol for research evaluation assessment in the Netherlands, www.knaw.nl/sep

-

Vught van F., Ziegele F (eds.) (2011), Design and testing for feasibility of a multidimensional global university ranking, CHERPA-network, Education and culture Commission, Contract 2009-1225/001-001, Bruxelles

- 1. Data la frequente presenza di articoli pubblicati su riviste non strettamente di settore, non si è ritenuto opportuno limitare la ricerca a ambiti disciplinari specifici (che peraltro differiscono nei diversi database).

- 2. La consultazione dei database è stata fatta tra il 16 e il 20 gennaio 2012, mentre l’elenco nominativo dei ricercatori del settore, distinto per fasce, è stato reperito sulla banca dati Miur il 16/1/2012.

- 3. Mentre gli indici h e g di Publish or Perish sono calcolati relativamente al periodo considerato, l’indice h di Scopus è stato invece riportato così come indicato, in quanto non veniva ricalcolato automaticamente escludendo le pubblicazioni anteriori al 2004; tende quindi a valutare maggiormente i ricercatori in attività da più tempo.

- 4. Una misura più appropriata della produttività, individuale o media per fascia, sarebbe la produzione scientifica rapportata agli anni di servizio.