Introduzione: riviste scientifiche e web

Quanto e come venti anni di internet (o, meglio, del web) hanno cambiato la comunicazione scientifica? In prima battuta si potrebbe sostenere che l’avvento di internet abbia modificato molto la comunicazione tra comunità scientifica e il resto della società, a cominciare dai policy maker e dalle istituzioni, creando maggiori opportunità di divulgazione tempestiva e accessibile e di interazione. Ma, forse, è più interessante chiedersi se e come la rete abbia condizionato la comunicazione all’interno della comunità scientifica. Basata da due secoli sulle riviste scientifiche e sul peer-reviewing, questa comunicazione può apparire poco influenzata dall’avvento di internet. In effetti, secondo molti, internet cambia il mezzo con cui si comunica non il contenuto che si comunica che è, in ultima analisi, ciò che interessa alla comunità scientifica1. Almeno fino 10 anni fa, questa interpretazione decisamente riduttiva del ruolo della rete è stata sposata da molti protagonisti di questa comunicazione: scienziati e, soprattutto, editori e case editrici delle riviste scientifiche. L’avvento di internet, al massimo, “costringeva” a rendere disponibili le riviste anche on line, ma senza dover ripensare i contenuti, le procedure del peer-reviewing, i tempi di costruzione e pubblicazione dei numeri e, soprattutto, la loro accessibilità.

Negli ultimi 10 anni, però, lo sviluppo di una idea diversa di fruizione della rete, molto più dinamica e interattiva (il cosiddetto Web 2.0)2, ha chiaramente mostrato come questo atteggiamento conservativo risultasse inadeguato rispetto alla portata dei cambiamenti. Con fatica, la comunità scientifica ha preso consapevolezza che la straordinaria accessibilità della rete sta abbattendo la barriera tra comunicazione interna alla comunità scientifica e comunicazione con l’esterno. Si arriva a postulare un’idea diversa di fare scienza, più partecipata e interattiva, meno gerarchizzata; la cosiddetta Science 2.0 (Waldrop, 2008; Buergelman et al., 2010; Bartling, 2011). Ne è un esempio il crescente ricorso ai blog da parte di scienziati o gruppi di ricercatori per rendere pubblici, presentare e discutere le proprie ricerche e i propri risultati (Curzel, 2011). Più tempestivo e, soprattutto, accessibile (sia come lessico che come costo) delle riviste scientifiche, il blog consente di andare oltre i confini, i tempi e, perché no?, le logiche imposte dalla comunità scientifica, entrando direttamente in comunicazione e interazione con una comunità nuova, in buona parte inesplorata e sostanzialmente illimitata. D’altro canto, se è vero che nel ristretto ambito della comunità scientifica la peer-review conferisce credibilità, è altresì innegabile che proprio i limiti del peer-revewing, in termini di efficacia, efficienza e trasparenza, risultano sempre più palesi. Questi limiti sono oggi tra i temi più dibattuti e controversi nella letteratura sulla valutazione della ricerca; letteratura che ha messo da tempo in luce i rischi di autoreferenzialità, di comportamenti speculativi e opportunistici, di tempi assai lunghi nella pubblicazione dei risultati e quindi di perdita di originalità (Lin, 2012)3.

Ma c’è di più. Le nuove potenzialità della rete e il social networking consentono anche a chi non è scienziato professionista (un imprenditore agricolo, per esempio), di portare alla luce contributi e risultati scientifici o sperimentali, di contribuire con idee e intuizioni4. Si tratta di un ritorno al passato, in realtà, a quando la ricerca scientifica non era un’attività codificata, né professionale e vi si dedicavano semplici appassionati o “dilettanti”5. Risulta difficile ritenere che un tale cambiamento non influisca sul ruolo del principale strumento di comunicazione interna alla comunità scientifica, cioè le riviste. Tradizionalmente queste filtrano la produzione di nuova conoscenza scientifica con il sistema del peer-reviewing, cioè passandola al severo (e anonimo) vaglio di altri componenti della comunità scientifica che, infine, approvano o meno la sua pubblicazione. Quanto più il peer-reviewing è rigoroso, selettivo e affidato a scienziati di massimo valore e reputazione, tanto più la rivista sarà in grado di selezionare i migliori nuovi contenuti. Ovviamente, i contenuti così selezionati saranno poi letti e, quindi, la loro validità potrà essere verificata ex-post. Ma pochi saranno davvero capaci di accedervi. Sia perché, a causa del complesso processo di produzione, le riviste scientifiche sono costose e difficili da reperire. Sia perché sono difficili da capire, molto tecniche e scritte in un linguaggio che solo gli introdotti in quella comunità possono comprendere. Quella delle riviste scientifiche, quindi, è una comunicazione sostanzialmente autoreferenziale, tutta costruita all’interno della comunità scientifica e fondata sulla fiducia che la comunità nutre rispetto a sé stessa.

La rivoluzione del web mette in discussione questa autoreferenzialità giacché aumenta l’accessibilità a questi contenuti scientifici: riduce i costi di produzione e di fruizione ed estende di molto l’utenza potenziale. Questa maggiore accessibilità, poi, induce coloro che producono i contenuti a cambiare linguaggio, ad uscire dal gergo, a rendersi più comprensibili. C’è il rischio di “volgarizzare” e “svendere” la scienza, per sua natura complessa e difficile? Può darsi (Waldrop, 2008). Qui però non si vuole stabilire che cosa sia giusto o sbagliato. Si vuole sottolineare come la maggiore accessibilità che internet garantisce non può che modificare sostanzialmente, e per sempre, la comunicazione basata sulle riviste.

Le grandi case editrici scientifiche stanno cercando di assecondare questo cambiamento, di fatto provando ad arginarlo (Monbiot, 2011), mediante l’introduzione delle versioni on-line delle riviste nonché la pubblicazione dei contenuti in early view (cioè non appena accettati per la pubblicazione ed editati). Ma queste soluzioni non eliminano la forte limitazione all’accesso imposta dagli elevati costi, né riducono i tempi di attesa in modo significativo. Si tratta, cioè, di soluzioni poco competitive rispetto alla capacità della rete di far circolare, discutere e contestare i contenuti praticamente in tempo reale. È inevitabile, perciò, che anche le riviste scientifiche debbano prima o poi obbedire alla legge fondamentale imposta dalla rete: garantire massima accessibilità e massima tempestività.

La figura 1 tenta di rappresentare graficamente il nuovo spazio che internet ha aperto, nonché il “vecchio” spazio che tende a restringersi progressivamente. Il web ha innescato un inesorabile spostamento della comunicazione scientifica, anche di più alto livello, verso una maggiore accessibilità. Di conseguenza, le tradizionali riviste scientifiche di rango medio-basso e le stesse riviste divulgative, che fanno della maggiore accessibilità (minor costo, maggiore diffusione e penetrazione) l’elemento distintivo rispetto alle riviste scientifiche tout court, rischiano di perdere la loro distintività. Quindi, rischia di venir meno la loro stessa ragione di esistere se non si avventurano in questo nuovo spazio di comunicazione aperto dal web. C’è un aspetto di questo movimento, tuttavia, che non è stato ancora sufficientemente messo in luce. La maggiore accessibilità indotta dal web si accompagna a un salto di qualità delle riviste stesse, almeno quando questa viene valutata secondo i parametri oggi maggiormente in voga, cioè i parametri citazionali. Infatti, la tesi che qui si sostiene è la seguente: poiché le citazioni di una rivista scientifica non dipendono solo da rilevanza/interesse dei contenuti ma anche dalla sua accessibilità, se si misura la qualità tramite le citazioni ne consegue che una maggiore accessibilità incrementa la qualità (almeno apparente) della rivista.

Figura 1 - Science 2.0: il movimento delle riviste scientifiche ai tempi del Web 2.0

Da comunicazione a valutazione

L’elemento che sembra sottovalutato circa la maggiore accessibilità che caratterizza la nuova comunicazione scientifica è come questa si intrecci con l’attuale dibattito sulla valutazione dei prodotti delle ricerca e, quindi, delle strutture e dello stesso personale di ricerca. Piaccia o meno, questo dibattito è oggi concentrato sull’uso dei cosiddetti indici bibliometrici (basati sul numero di pubblicazioni) e degli indici citazionali (basati sul numero di citazioni ricevute). Proprio grazie alle tecnologie informatiche e alla rete, è possibile quantificare e analizzare la produzione scientifica di una singola unità (un ricercatore, una istituzione di ricerca o una rivista), nonché verificarne la rilevanza (o l’impatto) tramite la quantificazione delle citazioni ricevute. Infatti, la citazione è divenuta l’unità di misura di riferimento per la valutazione dell’impatto dei prodotti della ricerca, su base oggettiva e quantitativa6.

Alla base di questo modo di procedere alla valutazione c’è una sorta di sillogismo: se un lavoro è scientificamente valido è molto citato; oggi è possibile misurare quanto un lavoro sia citato; è dunque possibile valutare quanto un lavoro sia scientificamente valido. Ma la premessa maggiore di questo sillogismo rischia di essere inesatta nella nuova comunicazione scientifica7. Il punto è che si citano (o almeno si dovrebbe) solo i lavori che si leggono; ma si leggono di più i lavori a cui si ha più facile accesso in quanto più facilmente rintracciabili, meno costosi, più comprensibili. In presenza di una comunicazione scientifica con un grado piuttosto diversificato di accessibilità, la premessa maggiore del sillogismo dovrebbe piuttosto essere: se un lavoro è scientificamente valido e molto accessibile, è molto citato. Anche la conclusione del sillogismo, quindi, dovrebbe cambiare: dal numero di citazioni è possibile valutare quanto un lavoro è scientificamente valido e accessibile.

Al pari del confronto tra autori o strutture, si è affermata l’idea che l’analisi delle citazioni consenta anche il confronto tra riviste: quante più citazioni ricevono i lavori pubblicati su una rivista, tanto maggiore è la sua rilevanza scientifica. Tuttavia, un’attenta comparazione delle riviste sulla scorta delle citazioni deve tener conto di diversi aspetti. In particolare, le riviste pubblicano un numero molto diverso di articoli ogni anno; hanno una diversa “anzianità”, quindi un “capitale” citabile di lavori di diversa ampiezza; presentano una diversa variabilità nella rilevanza/qualità scientifica dei lavori pubblicati. Inoltre, su tutti questi aspetti esercita una grande incidenza l’appartenenza alle diverse aree disciplinari (Harzig, 2010). Quindi, è assodato che, per confrontare in modo appropriato le riviste in termini citazionali, è necessario considerare una batteria di indicatori.

Nell’ultimo decennio sono stati elaborati indici citazionali che, tenendo conto di questi aspetti, ambiscono a rendere il confronto tra riviste il più oggettivo, stabile e trasparente possibile (Parnas, 2007). Il caso più noto è l’Impact Factor (IF), un indice sintetico che misura il numero medio di citazioni ricevute in un particolare anno da articoli pubblicati in una rivista nei due anni precedenti8. Ma l’IF è solo uno dei possibili indicatori ricavabili dal numero di lavori pubblicati dalla rivista e dal numero di citazioni da questi ricevute in un dato periodo di tempo. Partendo da questi dati elementari altri indicatori possono essere ricavati quale, banalmente, il numero di citazioni medie per articolo. Alcuni di questi, in particolare, consentono di indagare la distribuzione delle citazioni tra gli articoli stessi. Un primo esempio, in tal senso, è il Coefficiente di variazione (Cv) (dato dal rapporto tra deviazione standard delle citazioni e citazioni medie). Un Cv elevato indica che la rivista presenta lavori con molte citazioni9 e altre con poche o nessuna. Al contrario, un Cv basso indica che gli articoli pubblicati sulla rivista10 tendono ad avere un numero di citazioni abbastanza simile. Nel primo caso potremmo concludere che la rivista pubblica lavori di rilevanza/qualità piuttosto eterogenea; nel secondo caso, invece, la qualità dei lavori è abbastanza omogenea.

Negli ultimi anni, alcuni indici ad hoc sono stati messi a punto proprio per quantificare un impatto che tenga conto della dispersione delle citazioni. I due indici più impiegati sono l’indice h (Hirsch, 2005¸ Egghe e Rousseau, 2006) e l’indice g (Egghe, 2006). Il primo combina i due profili della rilevanza scientifica di una rivista: la quantità di contributi (numero di articoli) e la qualità degli stessi (o, meglio, la notorietà intesa come loro impatto in termini di citazioni) . L’indice g è stato proposto invece dell’indice h al fine di dare un maggiore peso ai lavori maggiormente citati tra quelli pubblicati nella rivista . Di norma, tuttavia, gli indici g e h sono abbastanza concordi nell’esprimere una valutazione comparativa delle riviste e, per costruzione, risultano anche abbastanza robusti rispetto a possibili errori nel computo del numero di citazioni dei singoli contributi.

Il caso delle riviste economico-agrarie

Usando questa batteria di indicatori è perciò possibile confrontare l’impatto delle riviste scientifiche di tipo tradizionale, e diverso rango, con quelle di nuova generazione e verificare se e come la maggiore accessibilità di queste si traduca in maggiore impatto. Su tale base, in questo paragrafo si comparano alcune riviste economico-agrarie. Il confronto viene condotto su un gruppo di sette riviste i cui dati citazionali vengono ricavati dalla banca dati Google Scholar (GS) consultata mediante il software gratuito Publish or Perish (PoP) (Harzig, 2010). La scelta di questo limitato ambito disciplinare è dettata dal fatto che in letteratura i confronti bibliometrici e citazionali risultano coerenti solo quando condotti all’interno di gruppi sostanzialmente omogenei dal punto di vista disciplinare11. Rimanendo nell’ambito agricolo, la disciplina economico-agraria sembra essere quella che meglio si presta agli obiettivi della presente analisi. In questa disciplina troviamo “storiche” riviste di riconosciuto prestigio, sia internazionali che di portata prevalentemente nazionale. Allo stesso tempo, nella disciplina sono apparse negli ultimi anni riviste di nuova generazione proprio con l’ambizione di sfruttare le potenzialità offerte dalla rete in termini di maggiore accessibilità. Le prime due riviste considerate sono l’American Journal of Agricultural Economics (AJAE) e la European Review of Agriculural Economics (ERAE), riviste con la più alta reputazione scientifica a livello internazionale. Riviste di limitata accessibilità, sia per i contenuti molto tecnici e il linguaggio accademico, sia per i costi di accesso. La seconda coppia di riviste è costituita dalla Rivista di Economia Agraria e da QA – Rivista dell’Associazione Rossi Doria (già La Questione Agraria). Anch’esse sono riviste di stampo prettamente accademico e limitata accessibilità, ma a diffusione quasi esclusivamente nazionale, quindi di rango inferiore alle precedenti.

A queste quattro riviste “tradizionali” se ne affiancano due di nuova generazione. Il Journal of Agricultural and Food Industrial Organization (JAFIO), una rivista di natura accademica ma disponibile esclusivamente on-line e scaricabile gratuitamente (almeno nel biennio di analisi qui considerato, 2007 e 2008), quindi connotata da maggiore accessibilità. La seconda rivista di nuova generazione è Agriregionieuropa (ARE) che punta tutto sulla massima accessibilità, non solo perché disponibile on-line gratuitamente, ma anche per il linguaggio che cerca di mantenersi semplice e accessibile ai fruitori esterni alla comunità scientifica. Allo stesso tempo, mantiene i caratteri della rivista scientifica di portata nazionale giacché la gran parte degli autori è costituita da ricercatori e accademici, e la selezione dei lavori segue i normali meccanismi di peer-reviewing delle riviste scientifiche.

L’ultima rivista è l’Informatore Agrario; chiaramente una rivista non accademica, a carattere prevalentemente divulgativo ma che ospita spesso contributi provenienti dal mondo della ricerca. Una rivista comunque di stampo tradizionale dal momento che rimane prevalente la fruizione nel formato cartaceo. E’ interessante, perciò, confrontare le sei riviste scientifiche precedenti con questa rivista di taglio decisamente diverso, con una numerosità di articoli pubblicati molto maggiore ma anche con limitata accessibilità. Sulla scorta di quanto discusso, la figura 1 propone una possibile mappatura di queste sette riviste. L’obiettivo è verificare se l’analisi bibliometrica e citazionale confermi o meno questa collocazione.

La scelta di consultare GS, attraverso PoP, piuttosto che una delle altre banca dati bibliografiche e citazionali di maggior reputazione in ambito scientifico (cioè Web of Science, WoS, di ISI-Thomson e Scopus di Elsevier) è dettata dal fatto che la copertura di queste ultime è molto limitata è non ricomprende tutte le riviste considerate12. Inoltre, WoS e Scopus non considerano le riviste in lingua non inglese, i libri, gli atti delle conferenze; tutte fonti di primaria importanza per le scienze sociali. GS, invece, si basa su una procedura automatica che “scandaglia” tutti i siti scientifici (riviste, istituzioni di ricerca, banche dati) alla ricerca sia di lavori scientifici che di relative citazioni. Quindi, la copertura di GS è molto ampia e offre maggiori garanzie di rappresentare il reale impatto delle riviste nella comunità scientifica. Ciò sembra particolarmente rilevante alla luce della suddetta evoluzione della comunicazione scientifica ai tempi del web che si indirizza verso sempre più numerosi e nuovi canali di comunicazione, e verso una molteplicità di fonti che non siano le sole riviste scientifiche ad alta reputazione.

Ciò non toglie che questa maggior copertura di GS la si ottenga al prezzo di una minore precisione nella rilevazione e attribuzione sia dei lavori che delle citazioni. La procedura automatizzata di ricerca dei lavori scientifici e delle relative citazioni condotta da GS può incorrere in qualche errore (Jacsó, 2006a, b)13. E’ bene notare come questi errori possono essere particolarmente rilevanti quando la ricerca riguarda singoli autori per i quali problemi di identificazione possono essere maggiori e i numeri complessivi, su cui l’errore incide, inferiori. Non così nel caso delle riviste.

In ogni caso, ogni qualvolta si conduca un’indagine bibliometrica e citazionale con GS è opportuno preventivamente confrontare i risultati che GS produce con i numeri reali della rivista (vedi tabella 1). Infatti, è bene essere consapevoli di eventuali mancanze nella ricerca dei dati da parte di GS al fine di poter correggere il calcolo degli indici citazionali h e g così che facciano riferimento al numero reale di lavori ed al numero reale di citazioni.

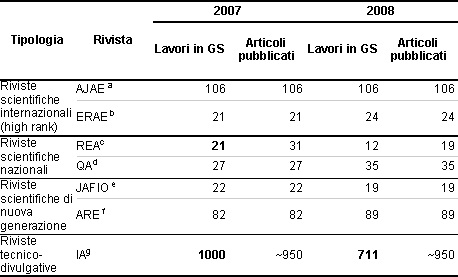

Tabella 1 - Articoli pubblicati e articoli rintracciati da GS nelle sette riviste economico agrarie considerate (2007 e 2008)

(a) GS riconosce come lavori distinti anche alcune appendici (14 e 11) agli articoli pubblicati. Il numero di lavori ottenuti da GS in prima battuta viene perciò corretto al fine di ottenere il numero esatto di articoli rispetto a cui calcolare gli indici citazionali. Le citazioni delle appendici vengono assegnate ai relativi articoli.

(b) GS riconosce come lavori distinti anche le recensioni ai volumi (20 e 17) pubblicate dalla rivista. Il numero di lavori ottenuti da GS in prima battuta viene perciò corretto al fine di ottenere il numero esatto di articoli rispetto a cui calcolare gli indici citazionali.

(c) GS rintraccia solo una parte degli articoli pubblicati sulla REA (14 e 11). Una ricerca individuale degli articoli pubblicati ma non rintracciati permette di individuarne altri su GS (7 e 1) in quanto attribuiti agli anni di effettiva uscita dei numeri e non agli anni di competenza degli stessi. Rimane il fatto che gli altri (10 e 7) non sono rintracciabili in GS né nel titolo in italiano né in inglese. Quindi gli indici citazionali vengono elaborati con riferimento solo agli articoli rintracciati (in grassetto) di cui, cioè, sono quantificate le citazioni.

(d) Per condurre la ricerca su GS in questo caso è necessario usare l’accortezza di specificare sia il nome “La Questione Agraria” che il nome “QA Rivista dell’Associazione Rossi-Doria. GS riconosce come lavori distinti i titoli in italiano ed in inglese di alcuni lavori (9 e 10). Il numero di lavori ottenuti da GS in prima battuta viene perciò corretto al fine di ottenere il numero esatto di articoli rispetto a cui calcolare gli indici citazionali e le citazioni, originariamente distinti e tra il titolo in italiano e in inglese, vengono assegnate tutte ai relativi articoli.

(e) Per il 2007 GS restituisce anche alcuni articoli pubblicati nei numeri degli anni precedenti, probabilmente prendendo come riferimento l’anno di immissione on line. Il numero di articoli e le relative citazioni vengono quindi corrette al fine di considerare solo i lavori effettivamente pubblicati nel 2007.

(f) Sono considerati solo i lavori “citabili” quindi vengono esclusi in contributi delle sezioni “Editoriale”, “Schede”, “Finestre”. In prima battuta, GS riesce a rintracciare solo una parte (circa il 50%) degli articoli pubblicati. Una ricerca individuale degli altri articoli pubblicati, tuttavia, permette di individuarli tutti in GS in quanto attribuiti ad altri anni rispetto a quello di effettiva pubblicazione oppure mancanti di anno di attribuzione.

(g) Il numero approssimativo di articoli con autore (quindi citabili) pubblicati in un anno dall’IA è di 950. GS ne rintraccia di più nel 2007 al punto che raggiunge il limite dei 1000 risultati. Probabilmente questo maggior numero è dovuto al fatto che GS attribuisce all’IA anche articoli pubblicati in realtà nei supplementi. Nel 2008 gli articoli rintracciati da GS sono invece in numero inferiore. In ogni caso, gli indici citazionali vengono elaborati con riferimento solo agli articoli rintracciati (in grassetto) di cui, cioè, sono quantificate le citazioni.

I risultati

L’estrazione dei risultati da GS (tramite PoP) per le sette riviste economico-agrarie considerate è stata effettuata nel periodo compreso tra l’1/2/2012 e il 6/2/2012 ed è stata realizzata estendendo l’indagine a tutta la banca dati, senza limitazioni tematiche14. Si è poi deciso di limitare l’indagine ai lavori pubblicati nelle riviste in un singolo anno. In particolare, si sono considerati gli anni 2007 e 2008, separatamente. Un periodo più ampio, infatti, implica un maggior numero di lavori considerati e quindi una maggiore probabilità di superare il limite di 1000 lavori15. Inoltre, considerare due anni separatamente consente, mediante il confronto, di verificare la robustezza di alcuni indici nel tempo. Vi è una precisa ragione per considerare gli anni 2007 e 2008 piuttosto che anni più recenti. Soprattutto nelle scienze sociali, i lavori pubblicati acquistano notorietà (cioè accumulano citazioni) con più lentezza rispetto alle scienze naturali. Peraltro, essendo eterogenee per taglio e target di comunicazione, le varie riviste possono avere una tempistica di impatto dei propri lavori abbastanza diversificata. È necessario, quindi, dare un tempo sufficiente a tutte le riviste di accumulare citazioni prima di procedere con il confronto. La letteratura ha messo in evidenza come, soprattutto nelle scienze sociali, cinque anni sono sufficienti per avere un quadro “maturo” degli indicatori citazionali (Harzig, 2010). Quindi, considerare tutte le citazioni dei lavori pubblicati nel 2007 e nel 2008 dal momento della pubblicazione fino ad oggi dovrebbe fornire una quadro abbastanza affidabile dell’impatto delle varie riviste16.

La tabella 1 riporta gli articoli individuati da GS negli anni 2007 e 2008 per le sette riviste considerate. Confrontando questo numero con gli articoli effettivamente pubblicati in quegli stessi anni, emerge che GS non riesce a rintracciare una parte significativa degli articoli pubblicati nella REA. Difficile spiegarne la causa, dal momento che gli stessi siti da cui la procedura automatica di GS estrae gli articoli regolarmente rintracciati dovrebbero riportare anche i lavori rimasti esclusi (Harzig, 2010). Ovviamente, non ci sono elementi per ritenere che i lavori non rintracciati risultino sistematicamente più o meno citati degli altri. Al contrario, è naturale ipotizzare che le citazioni dei lavori non rintracciati siano distribuite in maniera analoga a quelli dei quali è invece possibile disporre di osservazioni. Una tale assunzione consente di estendere anche ai lavori mancanti gli indicatori che dipendono dalla distribuzione delle citazioni, quali media, mediana e Cv. Non altrettanto si può dire per gli indici h e g. Questi, infatti, non dipendono solo dalla distribuzione ma anche dalla numerosità dei lavori considerati. In altre parole, i valori di h e g qui calcolati per la REA devono essere considerati approssimazioni per difetto, tanto più quanto maggiore è il numero di lavori non rintracciati da GS.

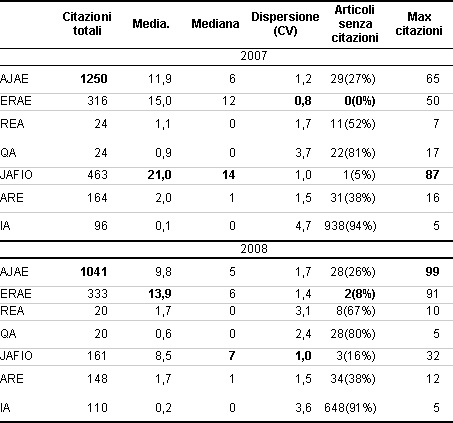

Tabella 2 - Statistiche descrittive relative alle citazioni ricevute dagli articoli pubblicati nelle sette riviste considerate (2007 e 2008)

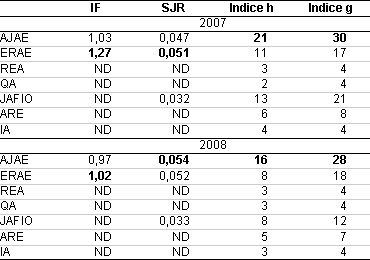

Tabella 3 - Indici citazionali (IF, SJR, h e g) delle sette riviste considerate (2007 e 2008)

La tabella 2 riporta alcune semplici statistiche descrittive relative alle citazioni mentre la tabella 3 riporta gli indici citazionali più articolati. Già dalla tabella 2, emerge con nettezza il diverso profilo delle varie riviste considerate. AJAE e ERAE sono riviste di grande impatto con citazioni medie elevate e simili nelle due riviste, sebbene si tratti di riviste con un numero differente di lavori pubblicati ogni anno e, quindi, di citazioni ricevute. Pubblicando un numero cinque volte maggiore di lavori rispetto all’ERAE, l’AJAE ottiene un maggiore impatto in termini di citazioni complessive (di conseguenza anche valori più elevati degli indici h e g; tabella 3) al costo, però, di una maggiore dispersione della “qualità” dei lavori, dal momento che è significativamente superiore il numero di lavori che non ricevono alcuna citazione; perciò, è inferiore il numero di citazioni mediane.

Netta la differenza rispetto a due altre riviste di stampo tradizionale ma di portata nazionale come REA e QA. Con un numero di lavori pubblicati dello stesso ordine di grandezza, le due riviste mostrano una quantità piuttosto bassa di citazioni complessive e, quindi, un basso numero di citazioni medie. Peraltro la dispersione è abbastanza accentuata e variabile negli anni, proprio perché sono pochi i lavori che ricevono un numero significativo di citazioni e che vanno, quindi, a condizionare i valori medi. Elevata la percentuale di lavori che non ricevono alcuna citazione e questo, soprattutto per QA, abbassa i valori medi e aumenta la dispersione. Significativo il fatto che per entrambe le riviste le citazioni mediane siano stabilmente zero.

Il quadro cambia abbastanza nettamente quando si passa alle due riviste di nuova generazione pubblicate on line con accesso gratuito. Delle due, quella con il più chiaro rango accademico (JAFIO) mostra livelli citazionali del tutto comparabili (anzi, persino superiori) alle riviste di massimo livello in ambito internazionale sebbene più “antiche”17 e con reputazione più consolidata. L’ampia accessibilità, cioè, ha consentito a JAFIO di entrare molto presto nel Gotha delle riviste scientifiche internazionali in ambito economico-agrario. Le stesse argomentazioni, ma su un altro livello, possono essere ribadite anche per ARE. Una rivista a diffusione prevalentemente nazionale, scientifica ma con un taglio più divulgativo rispetto a REA e QA, che riesce ad ottenere un numero di citazioni più elevato che, a sua volta, si riflette in indicatori citazionali non solo mediamente superiori ma anche con minore dispersione. Il fatto che questi risultati di ARE siano dovuti alla maggiore accessibilità e non tanto ad un suo carattere maggiormente divulgativo rispetto a REA e QA, lo dimostrano i dati ottenuti per IA, una rivista chiaramente tecnico-divulgativa ma di tipo tradizionale. Si noti, in questo caso, come il numero di citazioni rimanga inferiore ad ARE nonostante il numero molto maggiore di lavori pubblicati. Le citazioni medie e mediane sono le più basse e solo un numero molto limitato di lavori riporta qualche citazione. Risultato del tutto plausibile e atteso per una rivista che non ambisce ad avere un elevato impatto nella comunità scientifica.

Questi dati mostrano come l’indagine citazionale, pur con tutti i limiti e caveat sottolineati, fornisca una rappresentazione piuttosto efficace della collocazione e dell’impatto di una rivista nella comunità scientifica. Si noti, peraltro, che il confronto tra 2007 e 2008 mette in evidenza una sostanziale regolarità non solo delle posizioni relative delle riviste ma anche dei singoli indicatori di ogni rivista. Solo la REA mostra un significativo aumento della dispersione, in parte attribuibile al minor numero di lavori pubblicati, mentre il JAFIO registra un chiaro deterioramento delle perfomance citazionali, probabilmente attribuibile al necessario assestamento nella configurazione e nella collocazione editoriale di una giovane rivista18.

La tabella 3 mostra come questi risultati citazionali delle varie riviste si traducano in quegli indicatori sintetici oggi diffusamente usati e celebrati (ma anche contestati) che ne dovrebbero in qualche modo sintetizzare l’impatto. Si noti, in primo luogo, come il più famoso (e famigerato) di questi indici, l’IF, è disponibile solo per due riviste (AJAE e ERAE) dal momento che si tratta di un indice di proprietà della ISI-Thomson che viene perciò applicato solo alle riviste incluse nella banca dati WoS. Non si tratta di una grande mancanza, in realtà. Proprio dal confronto tra AJAE ed ERAE emerge come l’IF non dica nulla di realmente diverso e aggiuntivo di quanto non emerga dalle statistiche descrittive riportate in tabella 2. Stessa cosa dicasi per l’indice SJR, elaborato da Scopus e che include anche il JAFIO. Al contrario, sono indicatori che nascondono molte altre caratteristiche, in particolare la numerosità complessiva e la dispersione delle citazioni, che risultano invece molto indicative delle caratteristiche di una rivista. Più interessante è il confronto degli indici h e g delle varie riviste. In primo luogo, si noti che, ordinando le riviste secondo i due indici e nei due anni, si ottiene sostanzialmente la stessa classifica. La combinazione tra quantità e qualità espressa dai due indici (con g che valorizza maggiormente la qualità rispetto alla quantità), premia sempre l’AJAE; ERAE e JAFIO si contendono il secondo posto (con peggioramento della seconda passando dal 2007 al 2008), mentre tra le riviste nazionali ARE conquista il primato seguita dalla altre tre riviste che si collocano su livelli simili per il fatto che la qualità di REA e QA è compensata dalla quantità molto maggiore di IA. Probabilmente, questo dato penalizza la REA perché gli indici h e g risultano sottostimati per il fatto che GS non rintraccia tutti i lavori pubblicati. Tuttavia, tale effetto non sembra essere particolarmente rilevante: h e g rimangono invariati passando dal 2007 al 2008 sebbene il numero di lavori rintracciati diminuisca da 21 a 12.

Alcune considerazioni conclusive

L’analisi quantitativa ora presentata non pretende di derivare un giudizio sulla qualità scientifica delle riviste economico-agrarie considerate. E’ evidente che tale qualità si esprime in tanti diversi aspetti che non possono essere catturati dai dati qui considerati. E’ altresì opportuno ricordare che, questi dati possono contenere errori che non sono solo tipici di GS ma, in generale, di tutte le indagini citazionali condotte su banche dati bibliografiche. Piuttosto, l’evidenza qui riportata potrebbe segnalare il rischio di una valutazione basata solo sulle citazioni e che non tenga adeguatamente conto della diversa accessibilità delle riviste. Il rischio principale è che questa maggiore accessibilità esprima anche un “annacquamento” o una semplificazione dei contenuti scientifici. Sulla portata di questo rischio il presente contributo non può né vuole dire molto. In effetti, si tratta di un tema che meriterebbe ulteriori approfondimenti e verifiche.

Tuttavia, rimane il fatto che l’evidenza prodotta esprime comunque quel movimento nella comunicazione scientifica e, quindi, nella collocazione delle riviste scientifiche già raffigurato in figura 1. Non si tratta di intonare il de profundis per le riviste scientifiche, che continueranno a svolgere un ruolo centrale nella comunicazione scientifica anche in futuro. Certamente, però, la rivoluzione della rete costringe le riviste scientifiche a cambiare. La qualità senza un’adeguata quantità e, soprattutto, senza una maggiore accessibilità rischia di non essere sufficiente a garantire il futuro di molte riviste scientifiche di stampo tradizionale. Chi si è mosso in questa direzione è stato premiato dalla rete. ARE è un chiaro esempio dell’efficacia di questo mix di qualità, quantità e accessibilità.

Certo, il “giudizio” della rete non è un giudizio definitivo né un giudizio nel merito dei contenuti scientifici. Il web stesso, infatti, tende ad essere autoreferenziale, tendendo a citare ed esaltare i propri contenuti rispetto a quelli che, per scelta o necessità, risultano esclusi dal web. È tuttavia realistico immaginare un futuro in cui questo “giudizio” della rete sarà sempre più decisivo. Nei prossimi due decenni assisteremo ad un radicale ricambio generazionale sia di ricercatori e scienziati, che di policy maker, dirigenti e imprenditori agricoli. Questa nuova generazione sarà costituita da “nativi digitali”, soggetti per i quali accessibilità e tempestività non saranno più una grande, meravigliosa (e pericolosa) novità. Saranno la normalità. Chi non si adeguerà a questa normalità farà fatica a essere ascoltato (e letto).

Riferimenti bibliografici

-

Bartling, S. (2011). Four pillars of Science 2.0: How to enable web 2.0 for scientists and overcome the legacy gap. Research Gate, 18 January [link]

-

Belew, R.K. (2005). Scientific impact quantity and quality: Analysis of two sources of bibliographic data, arXiv:cs.IR/0504036 v1, 11 April.

-

Burgelman, J.C., Osimo, D., Bogdanowicz, M. (2010). Science 2.0 (change will happen...). First Monday, 15(7), 5 July [link]

-

Corsi, A., Defrancesco, E. (2012). La valutazione della produzione scientifica basata su peer-review e indicatori bibliometrici: esperienze in atto ed alcune riflessioni sul settore AGR/01. ARE – AgriRegioniEuropa (questo numero).

-

Curzel, E. (2011). Comunicare la scienza: si accende il dibattito tra blog e peer review. Corriere della Sera – Scienze (download del 11 luglio 2011).

-

Della Seta M., Cammarano R.R. (2006). Google Scholar and Web of Science: similarities and differences in citation analysis of scientific publications. Proceedings of the.10th Conference of the European Association for Health Information and Libraries. September 11-16, Cluj-Napoca

-

Egghe, L. (2006). Theory and practice of the g-index. Scientometrics, 69(1), 131-152

-

Egghe, L., Rousseau R. (2006), An informetric model for the Hirsch-index. Scientometrics, 69(1), 121-129

-

Harzig, A-W. (2010). The Publish or Perish Book. Your guide to effective and responsible citation analysis. Tarma Software Research Pty Ltd, Melbourne

-

Hirsch, J.E. (2005). An index to quantify an individual's scientific research output, arXiv:physics/0508025 v5, 29 settembre

-

Jacsó, P. (2005). Google Scholar: the pros and the cons. Online Information Review, 29(2), 208-214

-

Jacsó, P. (2006a). Dubious hit counts and cuckoo's eggs. Online Information Review, 30(2), 188-193

-

Jacsó, P. (2006b). Deflated, inflated and phantom citation counts. Online Information Review, 30(3), 297-309

-

Lin, T. (2012). Cracking Open the Scientific Process. The New York Times, 16 January

-

Meho, L.I., Yang, K. (2007). A New Era in Citation and Bibliometric Analyses: Web of Science, Scopus, and Google Scholar. Journal of the American Society for Information Science and Technology, 58(13), pp. 2105–2125

-

McLuhan, M. (1964). Understanding Media: The Extensions of Man. New York: McGraw Hill. Versione in lingua italiana: Gli strumenti del Comunicare Milano: Il Saggiatore

-

Monbiot, G. (2011). Academic publishers make Murdoch look like a socialist. The Guardian, 30 August

-

Parnas, D.L. (2007). Stop the numbers game. Communications of the ACM, 50(11), 19-21

-

Parnas, D.L. (2007). Stop the numbers game. Communications of the ACM, 50(11), 19-21

-

Ravetz, J. (2012). Sociology of science: keep standards high. Nature, 481(25), 2 January

-

Rothwell P.M., Martyn, C.N. (2000). Reproducibility of peer review in clinical neuroscience. Is agreement between reviewers any greater than would be expected by chance alone? Brain, 123 (Pt 9), 1964-1969

-

Vaughan, L., Shaw, D. (2008). A new look at evidence of scholarly citations in citation indexes and from web sources. Scientometrics, 74(2), 317-330

-

Waldrop, M.M. (2008). Science 2.0: great new tool, or great risk? Scientific American, 9 January

- 1. In realtà, che il mezzo condizioni il contenuto molto più di quanto non avvenga il contrario è un ormai un dato acquisito nello studio della comunicazione: “«il medium è il messaggio», perché è il medium che controlla e plasma le proporzioni e la forma dell’associazione e dell’azione umana. I contenuti, invece, cioè le utilizzazioni, di questi media possono essere diversi, ma non hanno alcuna influenza sulle forme dell’associazione umana” (McLuhan, 1964).

- 2. Con Web 2.0 si indica l'insieme di tutte quelle applicazioni online che permettono un elevato grado di interazione tra il sito e l'utente. Si passa, quindi, dalla semplice consultazione alla possibilità di contribuire alimentando il web con propri contenuti.

- 3. Per esempio, da tempo è stato messo in evidenza come l’esito del peer-reviewing non sempre garantisca circa la capacità di selezionare i contributi migliori rispetto ad una procedura puramente casuale (Rothwell e Martyn, 2000).

- 4. “L’avvento dei media digitali ha rivoluzionato la gestione dell’informazione scientifica e ha creato l’opportunità di un più ampio coinvolgimento nella produzione scientifica” (Ravetz, 2012) (traduzione dell’autore).

- 5. GalaxyZoo è uno degli esempi di successo dei cosiddetti citizen-science sites (siti di carattere scientifico aperti al contributo di “semplici” cittadini); un archivio aperto e ad accesso libero che raccoglie centinaia di migliaia di contributi di individuazione, classificazione e analisi di corpi celesti da parte di “dilettanti” e che sta dando un grande contributo alla ricerca astronomica. Un altro esempio di Science 2.0 di grande successo è ResearchGate un sito di social networking per scienziati attraverso il quale questi si scambiano materiali, opinioni e lavori scientifici al di fuori e al di là degli schemi imposti dalle tradizionali riviste scientifiche.

- 6. Fu Eugene Garfield dell’Institute of Scientific Information (Isi) di Philadelphia (tuttora uno dei leader mondiali nell’analisi bibliometrica) a sviluppare, già nel 1955, l’idea di un indice citazionale per le scienze, nella convinzione che più un articolo è citato, maggiore è il suo impatto, quindi la sua rilevanza, nella comunità scientifica.

- 7. Ci sono anche motivazioni più “classiche” per contestare l’uso della citazione come parametro di rilevanza scientifica. Le citazioni, infatti, possono anche essere negative e possono essere arbitrariamente e volontariamente omesse o incrementate mediante opportune strategie (il pesante ricorso all’autocitazione; l’accordo all’interno di gruppi ristretti di citazione reciproca, cioè i cosiddetti citation clubs; ecc.) (Harzig, 2010).

- 8. Di uso frequente anche il 5-year Impact Factor, basato sulle citazioni degli articoli pubblicati nei cinque anni precedenti. Alternativo all’IF (calcolato da ISI-Thomson a partire dalla banca dati WoS) è l’indicatore SJR (SCImago Journal Rank), calcolato a partire dalla banca dati Scopus e che attribuisce un peso alle citazioni ricevute da un articolo tenendo conto del prestigio delle riviste da cui tali citazioni provengono.

- 9. Una rivista ha un indice h=3 quando 3 degli N articoli pubblicati hanno almeno 3 citazioni ciascuno mentre gli altri N-3 articoli hanno ricevuto meno di 3 citazioni.

- 10. Ordinando gli articoli della rivista per numero di citazioni, un indice g=3 indica che i 3 articoli più citati hanno ricevuto, insieme, almeno 32=9 citazioni. L’indice g, quindi, è sempre uguale o maggiore dell’indice h.

- 11. “Il confronto di dati bibliometrici tra diversi ambiti disciplinari è, in genere, non appropriato” (Harzig, 2010).

- 12. Nel caso specifico, WoS e Scopus indicizzano solo AJAE e ERAE, non le altre cinque riviste. Della Seta e Cammarrano (2006), Meho e Yang (2007) e Harzig (2010) presentano un’analisi molto più dettagliata e completa di vantaggi e svantaggi dell’uso di GS rispetto a WoS e Scopus. Corsi e De Francesco (2012) utilizzano GS, WoS e Scopus, per estrarre i dati bibliometrici e citazionali relativi alla produzione scientifica degli economisti agrari italiani. A questi autori si rimanda per una più dettagliata discussione delle differenze emerse tra le tre banche dati.

- 13. Qui interessa notare, tuttavia, come questo tipo di errori nell’indagine bibliometrica e citazionale (anche detto citation noise) lo si riscontra anche nelle estrazioni condotte in WoS e Scopus che, anzi, in alcuni casi tendono ad essere anche maggiori (Belew, 2005).

- 14. I problemi di identificazione e attribuzione in GS emergono soprattutto quando si vincola la ricerca ad uno dei sette ambiti disciplinari a cui GS attribuisce i lavori. Non ponendo tale vincolo, GS consente di ottenere risultati più precisi.

- 15. GS ha un limite di visualizzazione di 1000 risultati per una determinata estrazione. Ancorché l’estrazione possa essere impostata al fine di contenere questo problema (appunto limitandola ad un solo anno, per esempio) è possibile che per riviste che pubblicano un numero molto elevato di articoli questo limite venga superato (vedi tabella 1). In ogni caso, i lavori che, superata la soglia dei 1000, vengono esclusi da GS sono quelli con un numero di citazioni inferiore rispetto ai lavori visualizzati. Quindi, il limite di 1000 risultati può al massimo determinare una piccola sovrastima degli indici citazionali di cui, comunque, è bene tener conto.

- 16. Vanno poi considerati altri aspetti nella scelta dell’anno da considerare. Alcune riviste sono piuttosto giovani, quindi sembra opportuno considerare un anno in cui non solo tutte le riviste siano già presenti, ma in cui possano essere considerate ormai consolidate, al di là dell’“anzianità”. In particolare, ARE nasce nel 2005 ed è quindi sembrato opportuno lasciare un paio di anni dalla nascita prima di considerare l’impatto in termini citazionali. Altre riviste, poi, tendono ad essere poco puntuali nell’uscita. La REA, per esempio, aveva all’epoca accumulato oltre un anno di ritardo nell’uscita: il primo numero dell’anno 2007, cioè, è uscito a metà del 2008. Quindi, è sembrato opportuno considerare un anno abbastanza indietro nel tempo per evitare che questo sistematico ritardo di uscita potesse condizionare in modo sensibile i risultati.

- 17. Il JAFIO nasce nel 2003, l’AJAE nel 1919, l’ERAE nel 1973.

- 18. Assestamento di fatto non ancora raggiunto dal momento che JAFIO ha di recente cambiato casa editrice con conseguente cambiamento anche della linea e della politica editoriale.